中美的量子计算突破,到底在搞些啥?现在还是“量子采样器”,量子比特的error rate最关键,目前还太高

量子很不好理解,但很神秘有趣,不少人就算不懂也愿意来吐槽凑趣。我以前是不懂的,但是努力学习之后明白了不少。最近不少人吹美国量子计算有突破,需要解释下,其实还差得远。

量子信息产业,分三块。量子精密测量,这是产业化做得最好的,是真的可以测出一些工业界有用的微观信息;还有军迷都搞不懂的量子雷达,据说能让隐形飞机彻底没意义。合肥几家企业都在搞,如国盾量子,主业是量子保密通信“京沪干线”这些,但也有量子精密测量产品了。国仪量子就全力做量子精密测量,如顺磁共振谱仪、电子显微镜,2023年营收就4亿了。

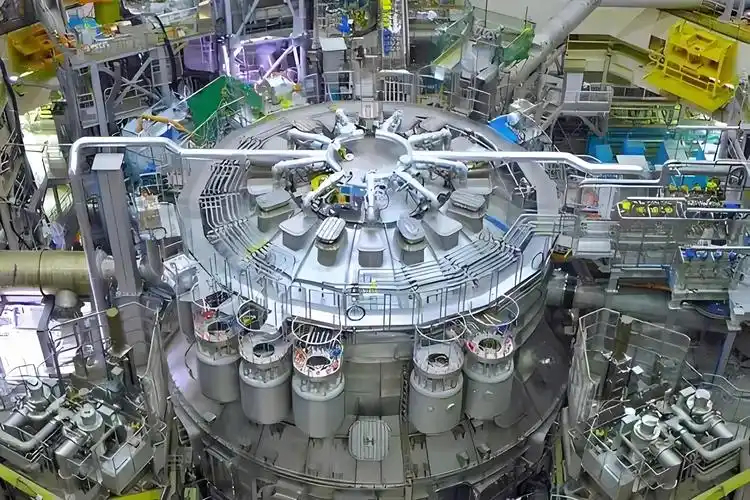

如果说量子保密通信、量子精密测量是产业化了,那量子计算就真没有。也有产业化卖“量子计算机”的,但其实是给科研机构提供实验性量子计算服务,不是工业用途。

量子计算的科研进展,倒是人们关注量子的焦点。如最近美国谷歌出了“可验证”的“量子回声”成果,能在不同量子计算机上复现,比传统算法快13000倍。而中国祖冲之一号二号三号、九章一号二号三号的成果都公布了,两个系列的四号也有消息透露。

祖冲之系列,量子比特数从一号的62个,发展到三号的105个,四号据说要200个,这是和美国类似的超导路线。还有光子路线的九章系列,一号是76个光子,三号255个光子了,四代据说要400光子。谷歌2019年的悬铃木是54比特,Willow是105比特。总之量子比特数、光量子数,在不断增加。

中美的这些量子计算机的大成果,全都在干一类事:量子采样。已经干了六七年了,在采样任务上,相对传统计算机的“量子优势”已经到10的15-25次方级别了,意思就是传统计算机要跑天文数字的时间才能有结果。说实在的,开始是突破,后面就觉得不太满意。

这些量子采样任务主要有两种,随机电路采样(RCS)、高斯波色采样(GBS),加些变种。这些任务有个特点,传统算法对采样的概率结果,不可能快速计算,要天文数字的年头才能有结果;而量子计算机可以快速跑多次,把概率结果测算出来。其本质是搞“量子体系行为预测”,当然就有“量子优势”了。个人觉得叫“经典劣势”为好,经典计算机做不好。

而经典计算机能做的事,量子计算机几乎全部做不好。如加法,量子计算机加100以上的数就满头冒汗。所以,“量子劣势”远比“量子优势”要多得多。

真正有意义的量子优势,量子计算理论分析已经说是可能的,如一直说的大质数因式分解、破解比特币加密算法等等。这些可不是预测量子体系的行为,而是很常见的经典困难问题,定义清楚谁都能听懂。

现在量子计算的机展,还处于很初级的阶段。在几乎所有“量子劣势”的问题上,不是劣势的问题,而是几乎没有靠谱结果!加减乘除这些,它不是劣势,而是无法得到“精确结果”。只在很少问题上有精确结果,如真用量子比特实现加法过程的,最大的和数是8;如果是量子实验模拟加法,最大和是2047,还是“254次重复测量后取最高频结果”,并不是一次精确加法成功的。

因此,可以理解为,量子计算做“量子体系行为”的概率统计,有几个任务搞得不错,经典计算机不行,没有快速算法。但是在需要精确性的量子比特最基础任务上,进展不大。

可以说,我们正处于“量子采样器”的时代,还没有进入“量子计算机”时代。新闻里将前者说成后者,是可以理解的宣传手法,要正确看待。

为什么“量子计算机”很难?因为量子芯片不行。记住一个关键问题:量子芯片的error rate,错误率太高。

经典芯片的物理门级error rate 有多低?每100万亿–1000 万亿次开关动作才可能出现一次硬失效!这才是芯片与计算“靠谱”的物理基础。

那量子芯片error rate到什么级别了?谷歌Willow的比特门error rate约为千分之0.8,这就是最高水平,比经典门电路差1000亿-10000亿倍。量子芯片里的门数量不会少,每个门还会跑多次,很快就会发现体系失去精确性了。就用一些麻烦透顶的“纠错”、“容错”算法去搞,还有统计性结果纠错,几千个量子比特根本不够用,上百万个才有理论意义。

所以,个人认为,最关键进展,就是量子比特的error rate。其它进展,很难有实际的量子计算工业用途。当然对量子体系不断深入了解,科研意义是很大的,不应过于功利。看到吹嘘美国量子计算进展的,得心里有数,看error rate就知道是啥级别的。