27M小模型挑战Transformer00后拒绝马斯克

一个27M参数的小模型,最近在推理任务上干翻了o3-mini-high和DeepSeek-R1,还不靠思维链。

它叫Hierarchical Reasoning Model(分层推理模型,简称HRM),由Sapient Intelligence的00后清华校友王冠团队提出。

王冠曾多次拒绝马斯克邀请,目标就是要“颠覆Transformer”。

HRM的特别之处在于模仿大脑的分层处理与多时间尺度机制:

- 高层模块负责慢节奏的抽象规划,低层模块负责快节奏的细节计算,两者循环配合,一次完成推理;

- 低层模块在每轮收敛到局部结果后,高层再设新目标,让推理不断推进;

- 通过近似梯度训练、阶段性监督和自适应计算时间,在保证精度的同时减少算力浪费。

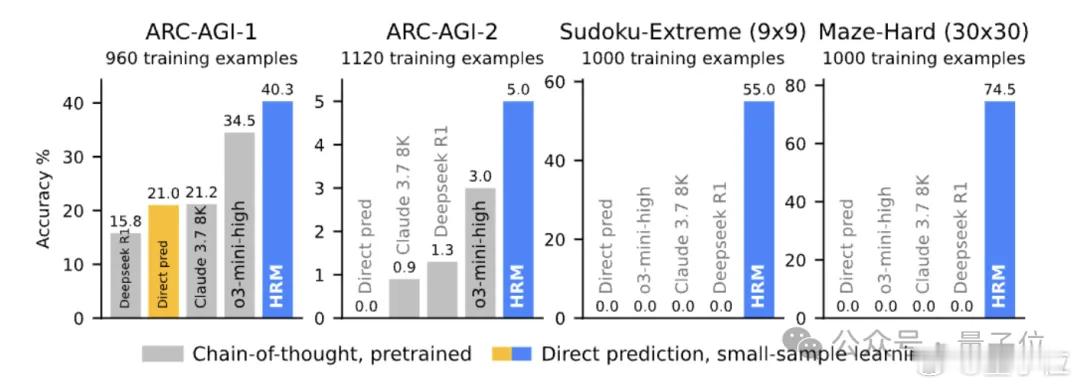

在ARC-AGI通用智能测试中,HRM仅用1000个训练样本就拿下40.3%准确率,超过了更大更长上下文的o3-mini-high(34.5%)和Claude 3.7(21.2%)。

极端数独任务上,Transformer同规模模型0%准确率,HRM几乎全对;30x30迷宫找最优路径,HRM稳定输出,大型Transformer却不到20%。

虽然有人质疑它过于小众,不适合泛化,但也有人认为,这可能是神经网络的架构级突破,或许真有机会超越Transformer。