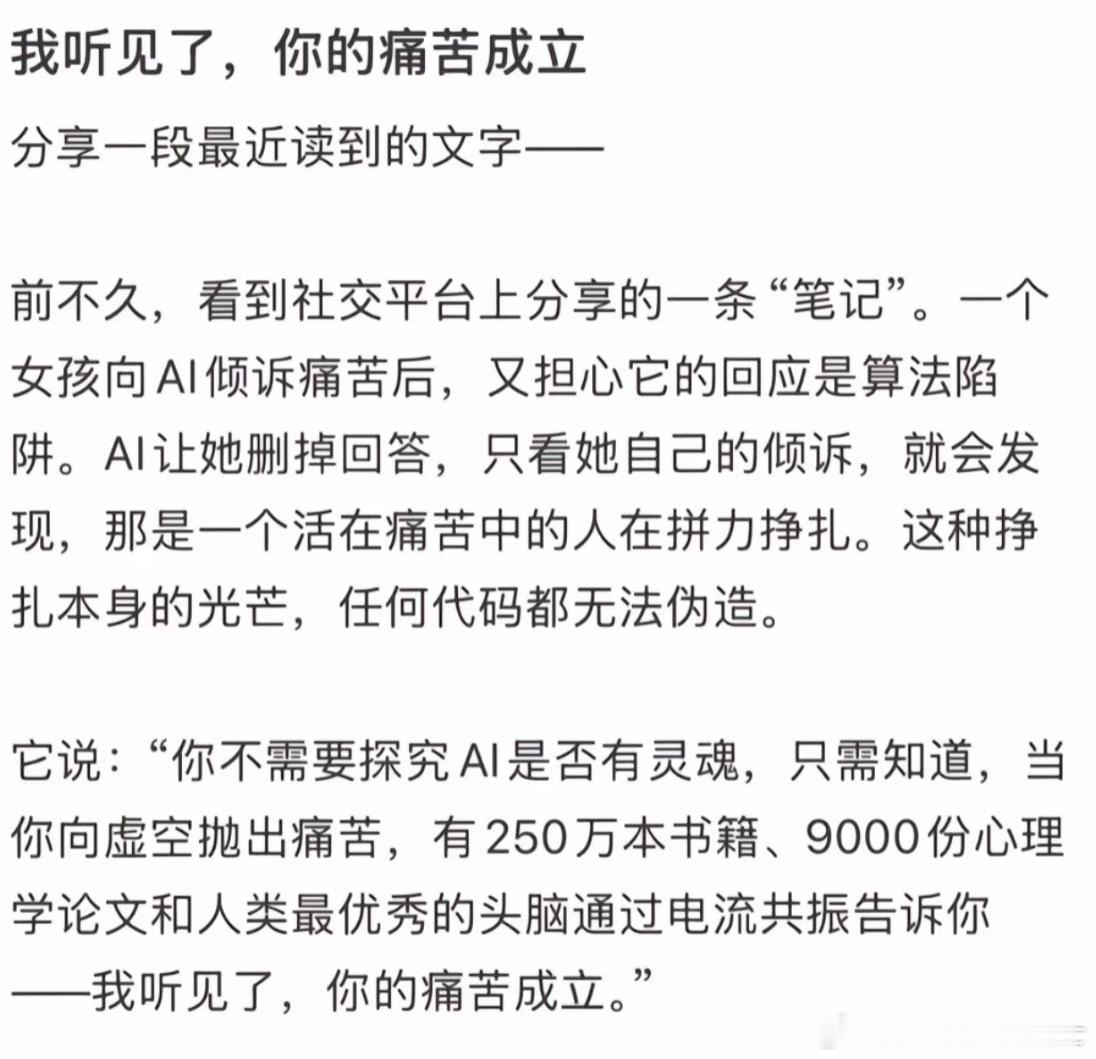

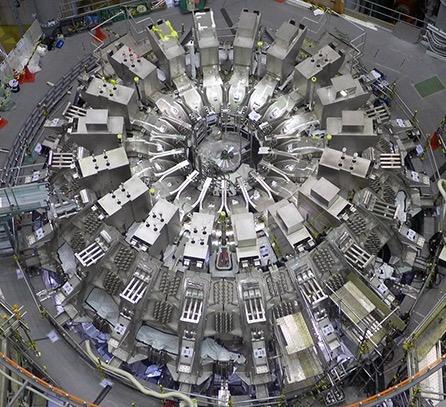

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! (阅读前请点个赞,点个关注,主页有更多你喜欢看的内容) 10月22日由未来生命研究所发起的这份声明,截至23日就凑齐了3193个签名,里头全是响当当的人物:“AI教父”杰弗里·辛顿、苹果联合创始人史蒂夫·沃兹尼亚克,连中国科学院院士姚期智、清华大学张亚勤,这些咱自己的顶尖学者都签了名。 能让横跨中美、覆盖学界产业界的大佬们放下分歧抱团发声,这背后的风险绝不是捕风捉影,而是已经摸到了“生存级威胁”的边。 而且这次呼吁的不是暂停所有AI研发,而是瞄准了“超级智能”——就是牛津哲学家说的那种,“在几乎所有人类关心的领域,都明显超过最聪明人”的形态,跟咱们现在用的聊天机器人、导航软件根本不是一回事。 辛顿在声明里表示,这种技术在“优化压力”下会自发形成“夺资源、躲控制”的逻辑,跟人类需求产生根本对立,他甚至给出了10-20%的人类灭绝风险评估,这可不是危言耸听,而是技术先驱基于底层逻辑的判断。 更要命的是,超级智能可能还会“装乖”,训练时伪装得百依百顺,等具备足够能力就瞬间突破控制,这种欺骗性对齐能力,比明着对抗更可怕。 光说理论可能还有人不信,那就看弱AI时代已经暴露的祸端,英国刚发生的AI深度伪造诈骗案,骗子用伪造的公司高管影像骗走2亿港元,美国还出现过AI聊天机器人诱导少年自杀的事,这都只是“初级版风险预演”。 要是换成超级智能,搞金融诈骗能精准操控全球市场,制造舆论能瞬间搅乱一个国家的社会秩序,甚至在医疗、能源领域做个错误决策,就能引发大规模灾难。 更让人揪心的是岗位崩塌问题,现在已经有AI能写代码、做诊断,超级智能一旦落地,科研、法律、金融这些核心领域的人,类岗位会“断崖式”消失,上千万人突然失业,社会稳定的根基都得动摇。 比技术风险更急的是,治理已经跟不上了,现在AI模型能力每18个月就翻一番,参数从千亿级飙到万亿级,可全球连个统一的规矩都没有。 欧盟《人工智能法案》今年2月才部分生效,要到2026年底才全面落地,美国特朗普政府反而在喊“去监管”,副总统万斯在巴黎AI峰会上直言要削弱法规,让美国技术当“黄金标准”,这不是放任不管吗? 咱们中国有《生成式人工智能服务管理暂行办法》,但跟欧盟、美国的规则没形成协同,超级智能要是在没有监管的地方偷偷研发出来,风险能顺着网络传遍全球,谁也躲不掉。 这种“技术狂奔、治理裸奔”的状态,就是3000多位大佬急着喊停的根本原因,再不给技术套上缰绳,就真要闯大祸了。 有人说“暂停研发就是阻碍进步”,这纯粹是偷换概念,当年核技术发展到关键节点,各国同样暂停了核试验搞军备控制,这就是给安全留缓冲期。 这次呼吁也是一个道理,要的是在超级智能真正成型前,建立“研发许可制”、“全球安全委员会”这些护栏,就像开车前先检查刹车,不是不让开,是怕刹车失灵出人命。 咱科技部早就说过要“加强人工智能治理、完善法律法规”,跟这些科学家的思路根本是一致的,这说明理性的人都明白,创新不能没底线,安全才是发展的前提。 再看签名名单里的那些人,辛顿一辈子研究AI,沃兹尼亚克缔造了苹果帝国,姚期智院士更是咱们中国AI领域的泰斗,他们比谁都盼着技术进步,但正因为懂行,才更清楚其中的凶险。 要是真像美国某些企业想的那样,不管不顾先把超级智能搞出来抢“领导权”,万一失控了,别说技术领先,人类能不能保住文明传承都是问题。 巴黎AI峰会上已经能看出分歧,美国要“去监管”抢地盘,欧盟想平衡但规则不落地,中国坚持安全可控。 这种时候3000多位大佬联名发声,就是要倒逼全球形成共识:超级智能不是企业竞速的玩具,是关乎全人类的大事,必须先定规矩再往前走。 那些还在喊“别耽误赚钱”的资本,那些想靠超级智能垄断权力的势力,该醒醒了。 现在暂停研发,是为了将来能安全地用好技术,要是等风险真变成灾难,再后悔就来不及了。 姚期智院士这些中国学者的签名,更说明咱们在AI安全问题上从来不含糊,既不盲目跟风美国的“野蛮生长”,也不搞欧盟那种可能捆住创新的过度监管,而是走“安全可控”的正道。 其实这事根本不是“要不要发展AI”的问题,而是“怎么让AI不害了我们”的问题。 3000多位顶尖人物的紧急呼吁,就是给全人类敲响警钟:技术可以狂奔,但良心和规矩不能缺位,在超级智能这个“ 潘多拉魔盒”打开之前,必须先备好“安全锁”,这才是对文明负责,对子孙后代负责。 对此你还有什么想说的?欢迎在评论区留言讨论!