[LG]《K2-Think: A Parameter-Efficient Reasoning System》Z Cheng, R Fan, S Hao, T W. Killian... [Mohamed bin Zayed University of Artificial Intelligence] (2025)

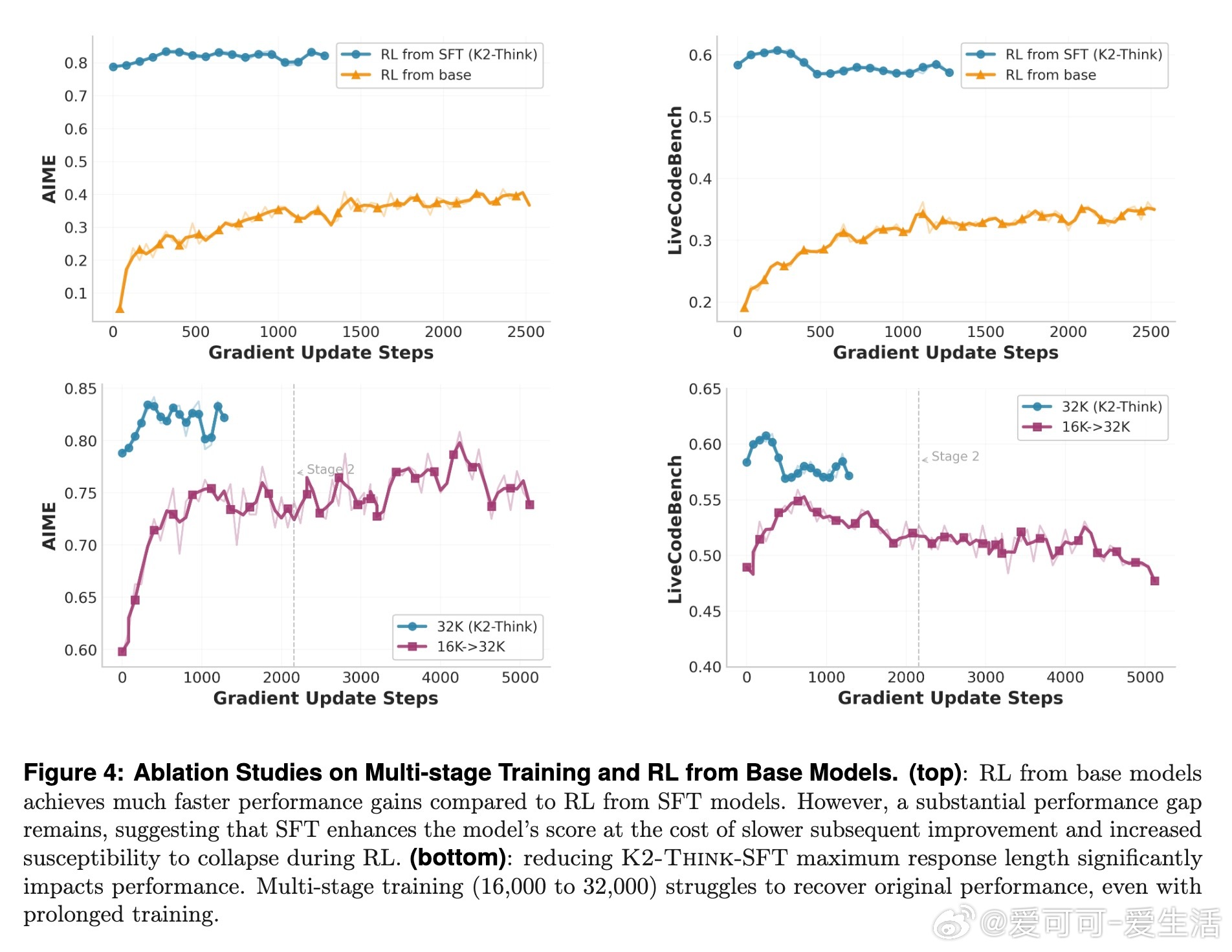

K2-Think:32B参数级别的推理系统,凭借六大技术支柱,实现对标甚至超越百亿规模模型的前沿性能,推动开源推理模型迈入新高度。

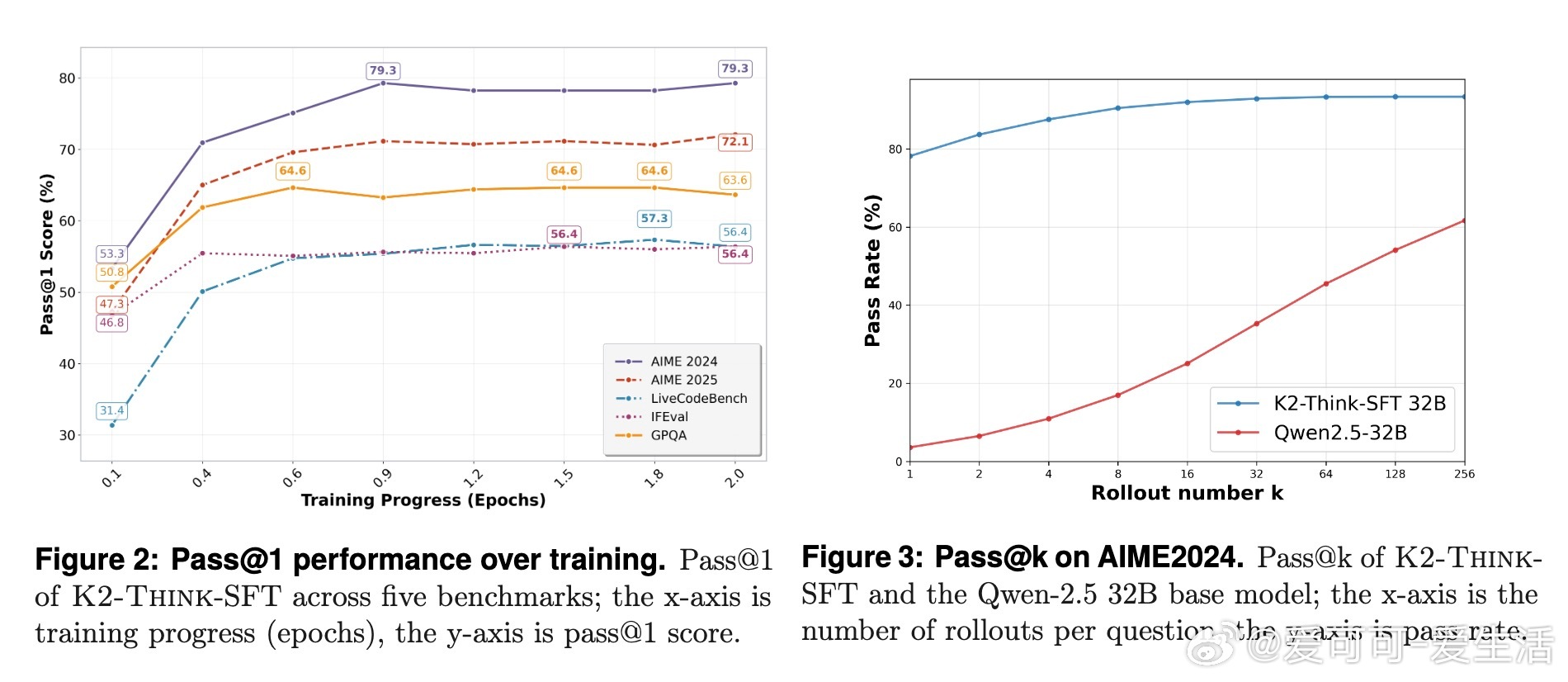

• 基于Qwen2.5-32B模型,核心技术包括长链式思维监督微调(SFT)、带可验证奖励的强化学习(RLVR)、推理前的Agent规划、测试时规模放大、投机解码及推理优化硬件部署。

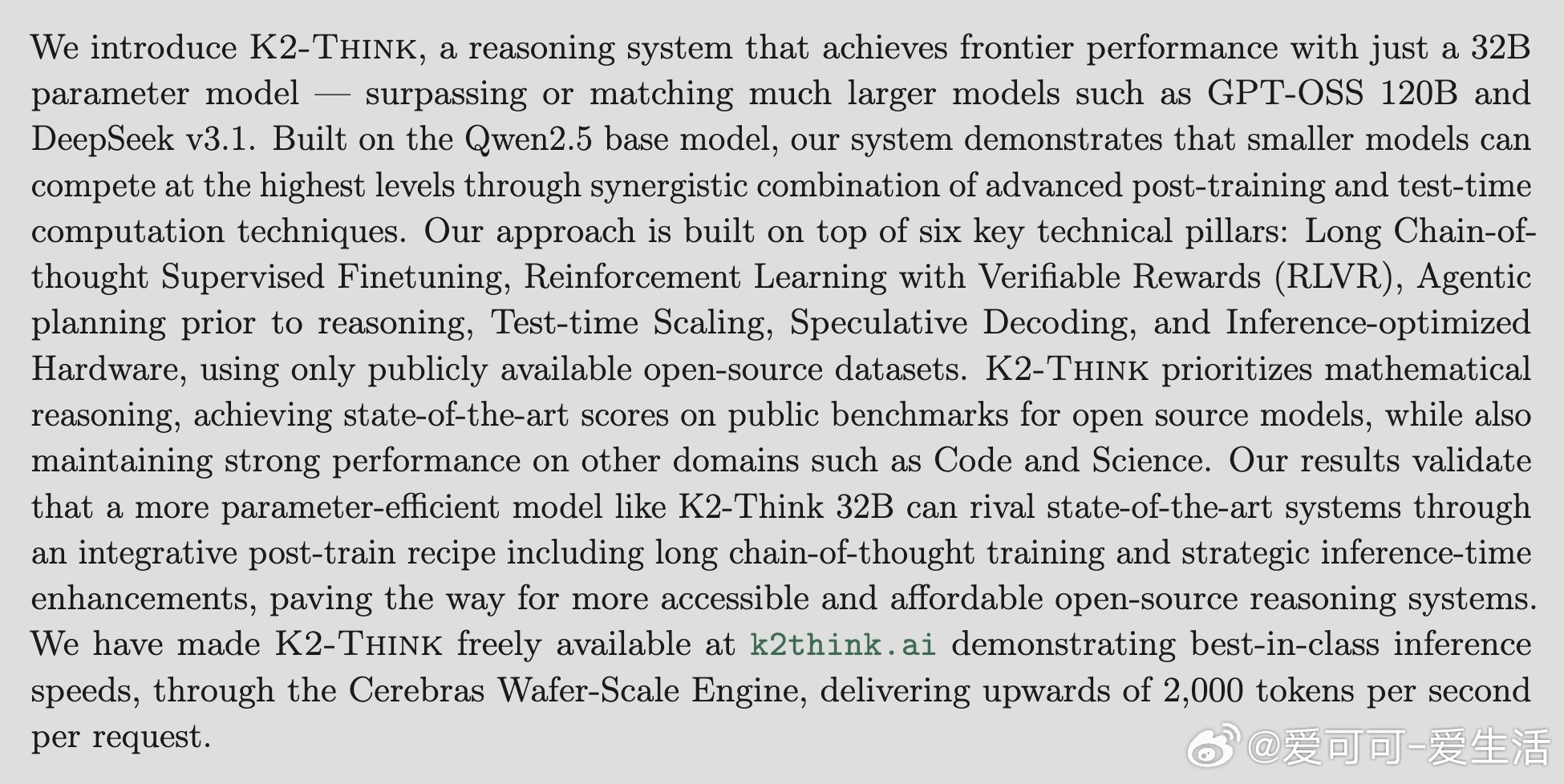

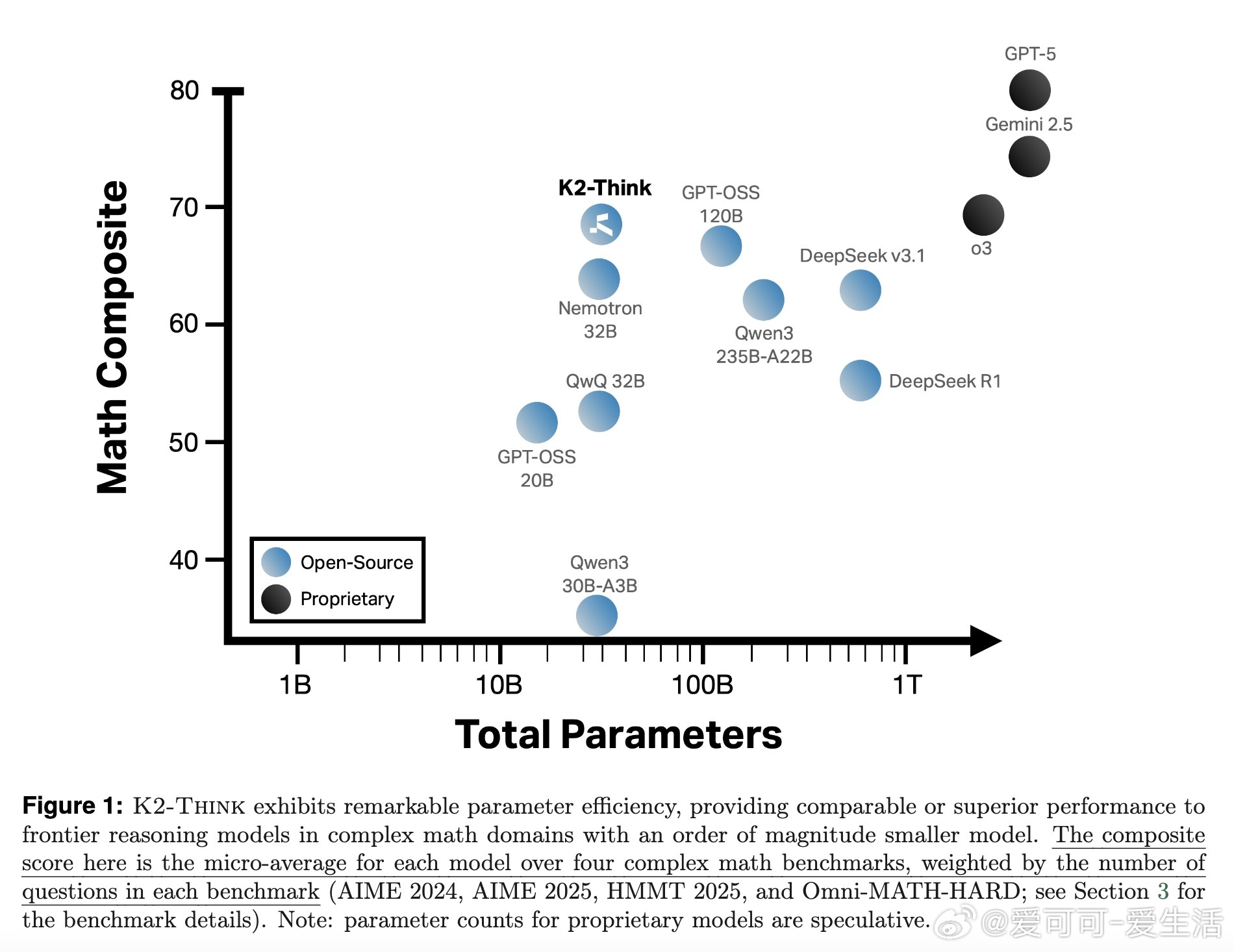

• 在数学推理领域表现抢眼,AIME、HMMT、Omni-MATH-HARD等竞赛级别测试中,32B参数模型成绩媲美甚至超越DeepSeek v3.1(671B)和GPT-OSS 120B。

• 多领域适用,代码生成和科学推理同样具备强劲实力,LiveCodeBench得分领先同规模模型,科学推理表现稳定。

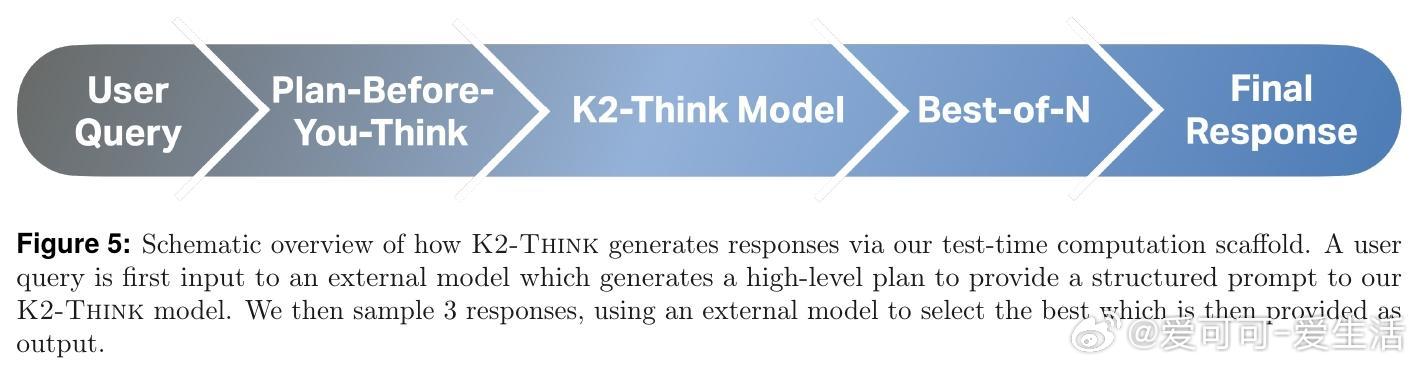

• 测试时“Plan-Before-You-Think”规划策略与Best-of-N采样协同提升推理质量,生成答案更简洁,减少最高近12%Token使用量,兼顾效率与准确率。

• 采用Cerebras Wafer-Scale Engine硬件,实现超2000 tokens/s的推理速度,响应时间从数分钟缩短至十几秒,极大改善交互体验。

• 安全性评估显示强大的有害内容拒绝和对话鲁棒性,网络安全与绕过防御仍有提升空间,团队正积极优化以确保公开部署的安全可靠。

心得:

1. 小而精的模型通过合理后训练和推理时计算策略,完全可以“以少胜多”,实现在极具挑战性的数学推理中与超大规模模型抗衡。

2. 多领域覆盖的训练数据和奖励机制对泛化能力至关重要,特别是逻辑和模拟等冷门领域需专门强化训练方能显著提升。

3. 推理前的高层规划不仅提升准确率,还能显著压缩生成长度,反映出类人类思维中“先规划再思考”的高效认知路径。

探索详情🔗arxiv.org/abs/2509.07604

模型与代码🔗huggingface.co/LLM360/K2-Think

开源项目🔗github.com/MBZUAI-IFM/K2-Think-SFT

推理框架🔗github.com/MBZUAI-IFM/K2-Think-Inference

在线体验🔗k2think.ai

人工智能大模型推理系统开源机器学习数学推理强化学习计算机科学