这个 Paper 暴露了 LLM 的阴暗面。

我一直以为 LLM 神经网络是对训练数据的规律抽象。但是没想到,同时,他也是对训练数据的完整记忆。

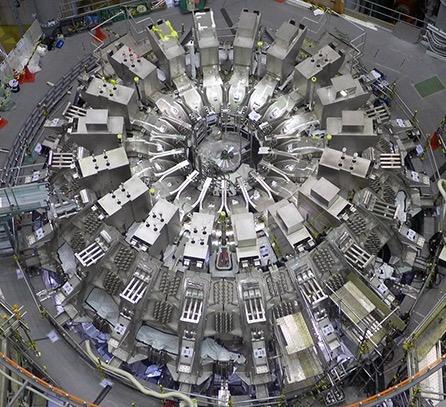

模型也可以看作是对训练数据做了一种高纬存储。paper 在数学上证明,Transformer 语言模型是可以无损保存训练数据的(从初始化到训练完成):数据并没有被抽象化,而是被完美地保存在高维空间中。

该理论已在GPT-2、Gemma、Llama等多个模型上进行了测试。对于数十亿个提示词,复原率为100%。

我们之前无法完整得到训练数据,并非因为模型抽象了数据,而是因为我们的分析能力不足。(蒸馏可以看作一种低成本的训练数据还原方式)。

所以,类似模型训练的数据墙,就是模型其实已经记不住新的东西了的意思?

而规模法则,其实是不停的扩展存储的过程(更大规模,更多数据,保存更多数据到高纬空间), SLM 的原理,其实是平衡抽象规律和记忆数据的关系?