[LG]《Encode, Think, Decode: Scaling test-time reasoning with recursive latent thoughts》Y Koishekenov, A Lipani, N Cancedda [FAIR at Meta & University College London] (2025)

新方法提升大语言模型推理能力

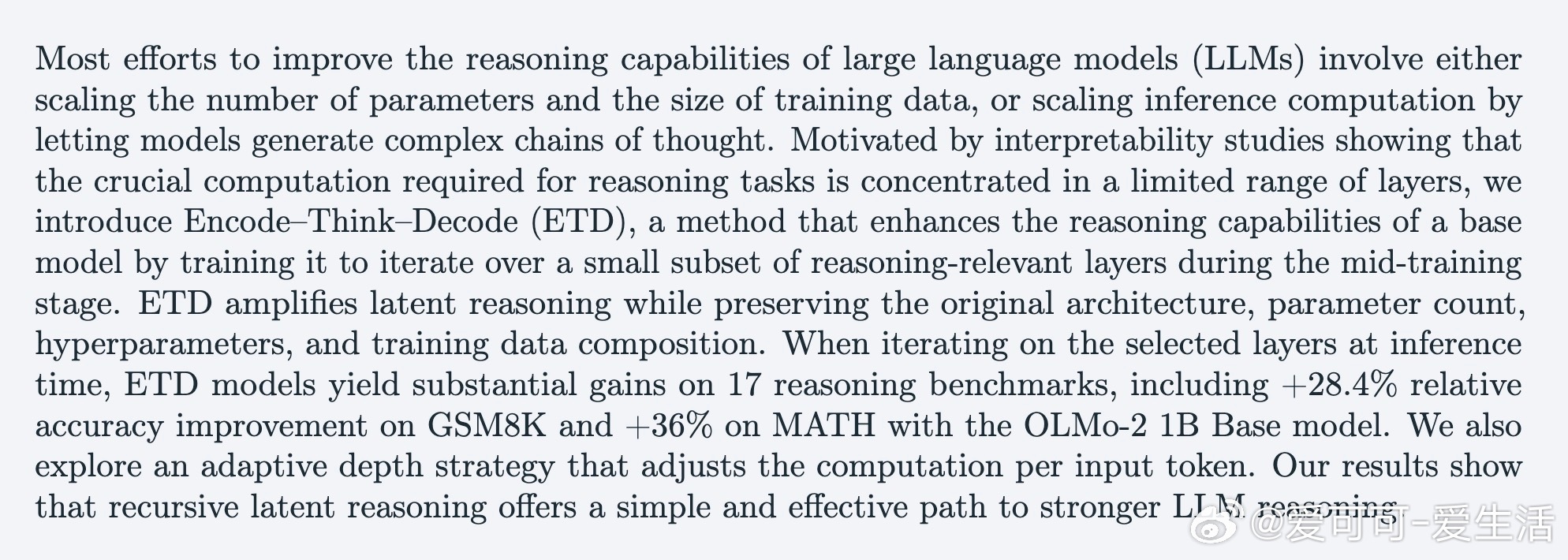

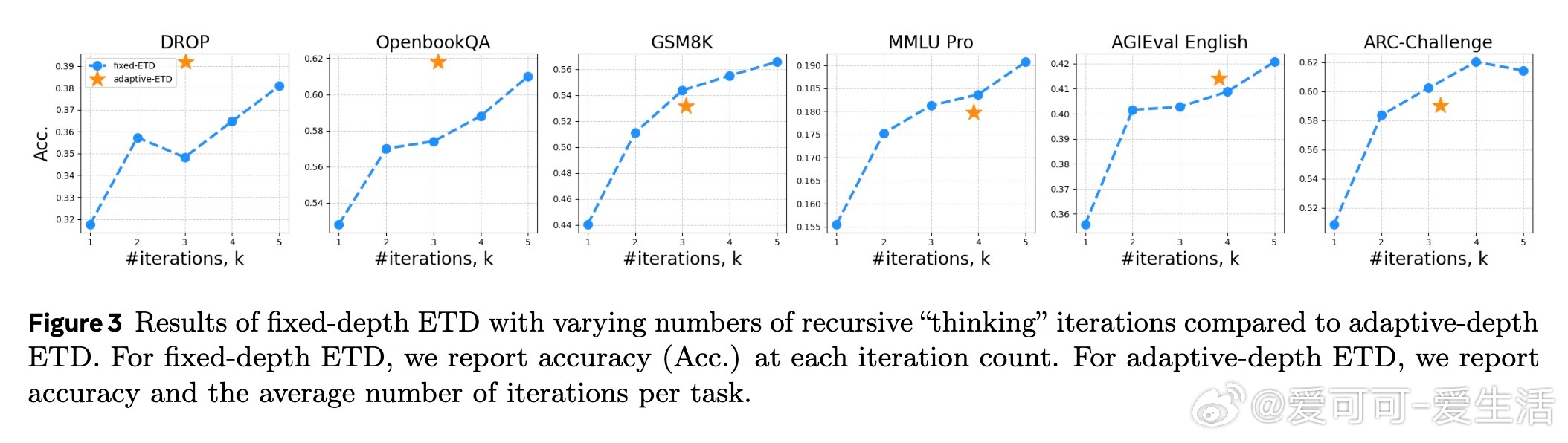

近期论文《Encode, Think, Decode: Scaling test-time reasoning with recursive latent thoughts》提出ETD框架,通过在推理相关的少数层递归迭代“思考”过程,显著提升模型推理表现,无需增加参数或改变训练数据。

核心思路:

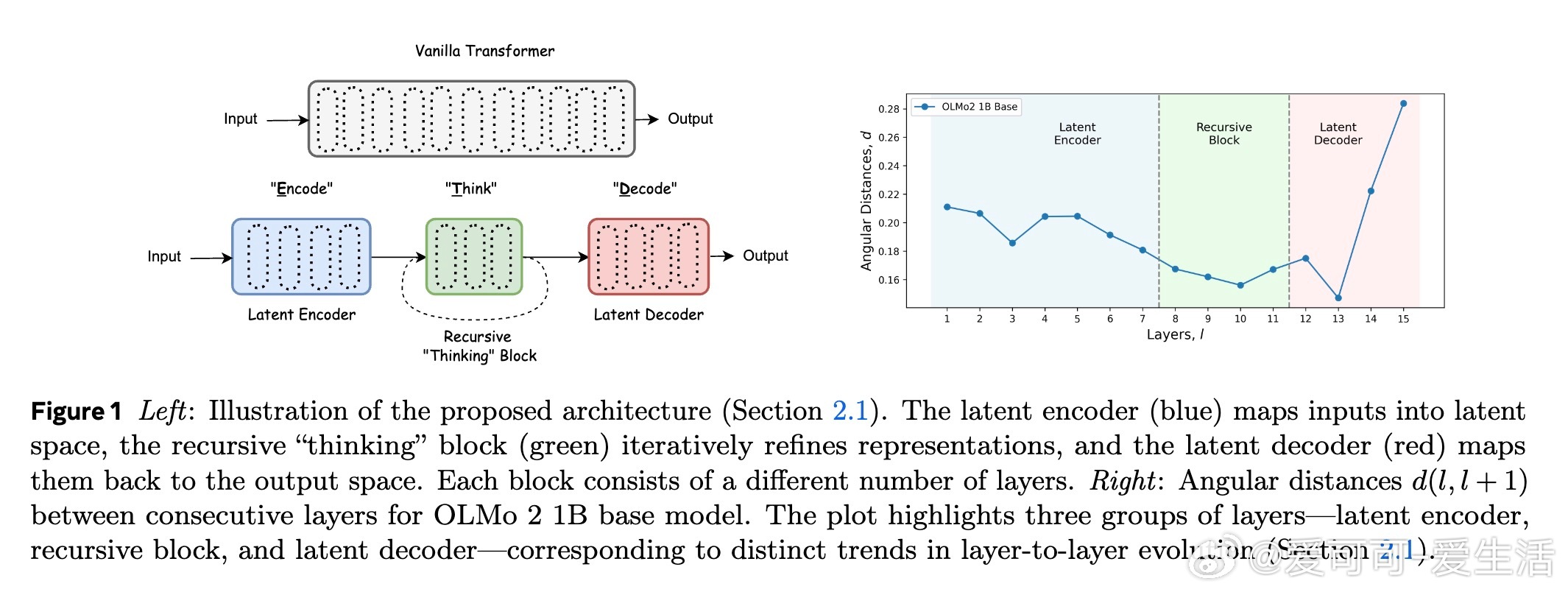

1️⃣ 分层分析:将Transformer分为编码层、递归“思考”层和解码层,专注递归迭代中间4层,增强潜在推理能力。

2️⃣ 训练策略:在中期训练阶段加入递归迭代,保持参数和数据不变,直接提升推理能力。

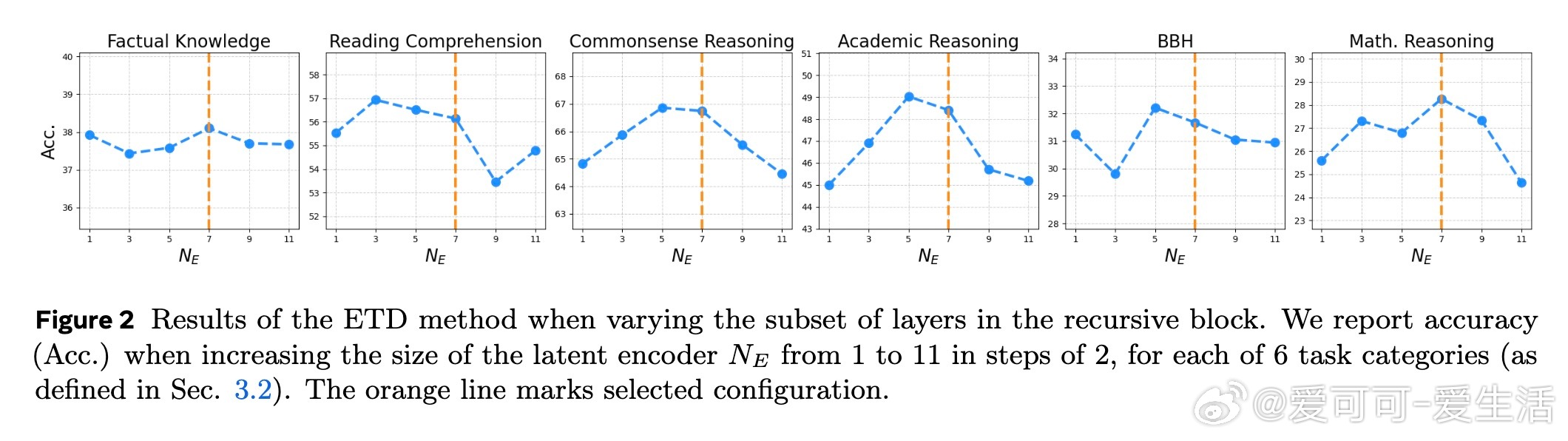

3️⃣ 动态推理深度:引入自适应计算机制,根据输入复杂度动态决定迭代次数,效率更高。

4️⃣ 多任务验证:在17个推理任务上测试,特别是数学题GSM8K和MATH分别提升28.4%和36%准确率。

创新点:

- 首次基于模型层间角度变化分析,科学选定递归层,精准放大推理相关计算。

- 递归深度设计兼顾效率与效果,优于全层递归或其他递归策略。

- 自适应深度机制实现推理资源智能分配,兼顾性能和计算成本。

意义启示:

ETD展示了通过“深度递归思考”可不依赖规模扩张而强化LLM推理的可行路径,结合模型结构解释为未来高效推理模型设计提供重要参考。

详情与实验数据见论文:

大语言模型 推理能力 递归深度 ETD 机器学习 AI研究