大模型遗忘机制研究

研究背景与问题

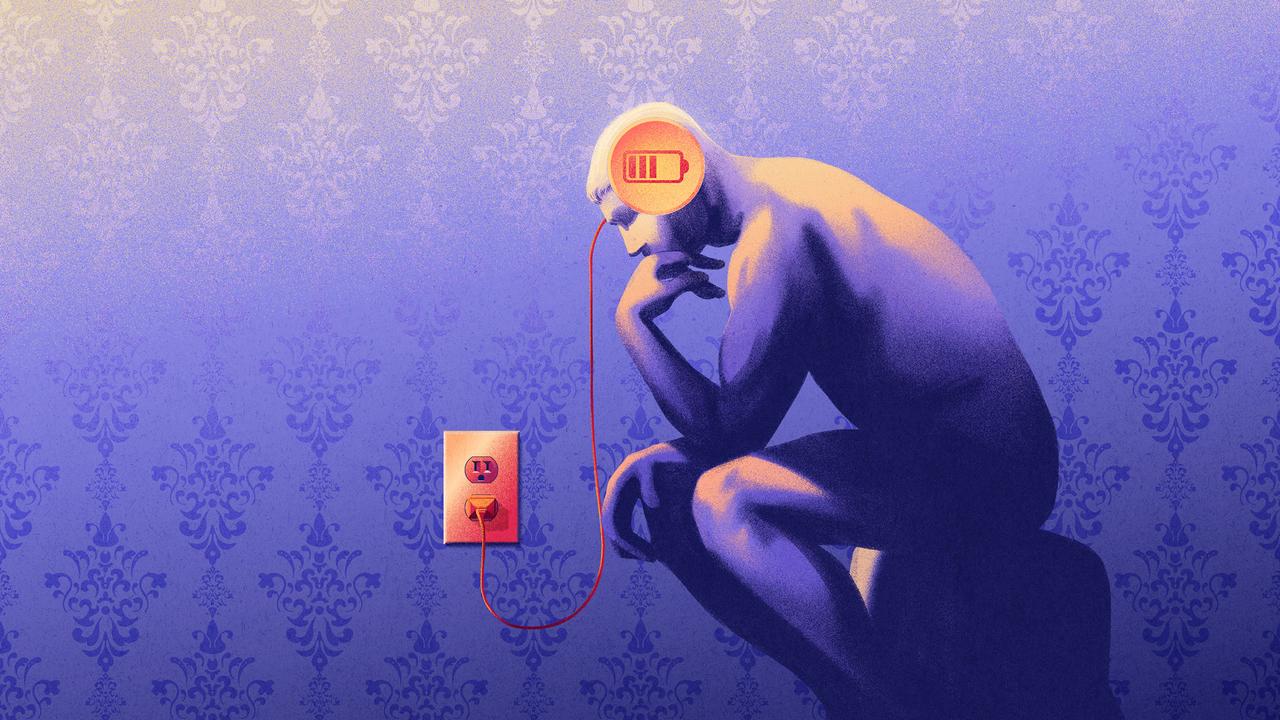

大语言模型(LLMs)存在隐私风险,训练中可能记忆敏感信息。机器遗忘(Machine Unlearning)技术旨在选择性抹除特定知识,但需区分“可逆性遗忘”与“不可逆遗忘”。

核心发现

1. 结构变化决定遗忘性质:

• 可逆遗忘:仅行为表现下降,内部结构未变(如PCA相似性高)。

• 不可逆遗忘:多层协同扰动导致结构漂移(PCA方向旋转、Fisher矩阵破坏)。

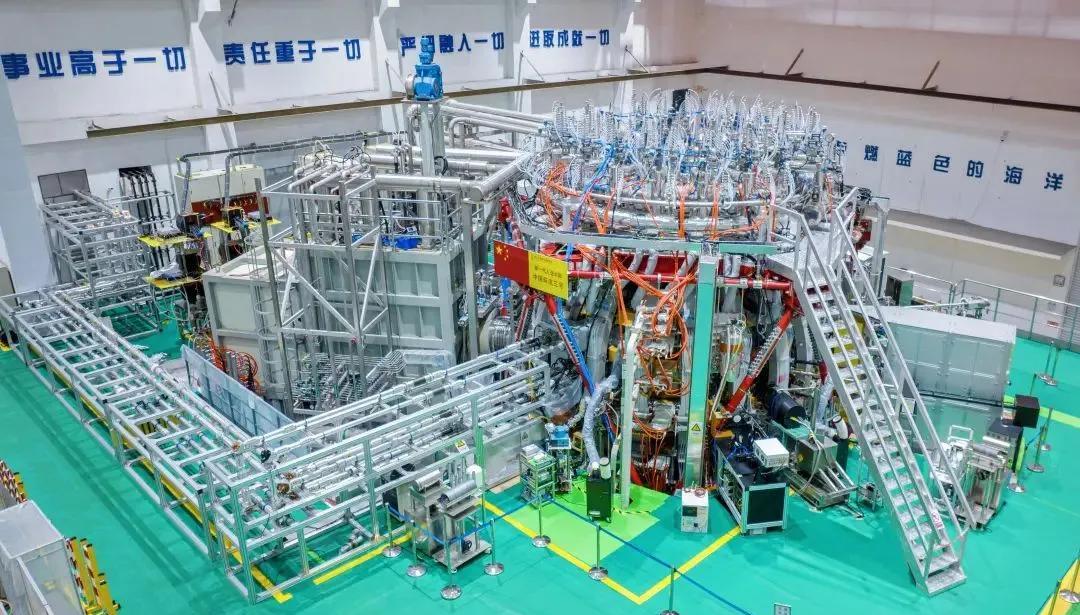

2. 诊断工具与实验验证:

• 工具:PCA相似性、CKA分析、Fisher信息矩阵。

• 实验:单次遗忘多可恢复,持续遗忘(如100条请求)易引发崩溃。

3. 方法对比:

• GA/RLabel破坏性强,GA+KL和NPO稳定性更高。

4. 潜在益处:

• Relearning后可能提升模型性能,暗示遗忘具正则化效果。

应用与展望

结构诊断工具可定位破坏位置,支持设计可控、安全的遗忘机制。论文与代码已开源,推动技术发展。