[LG]《Reasoning Models Can be Accurately Pruned Via Chain-of-Thought Reconstruction》R Lucas, K Behdin, Z Wang, Q Song... [LinkedIn] (2025)

压缩推理型大语言模型的难题迎来突破:仅靠传统基于输入的剪枝方法,推理性能大幅下降且推理时间反而延长。新策略“Reasoning-Aware Compression”(RAC)通过联合重建输入及模型自生成的链式思维激活,显著提升剪枝后推理准确率与效率。

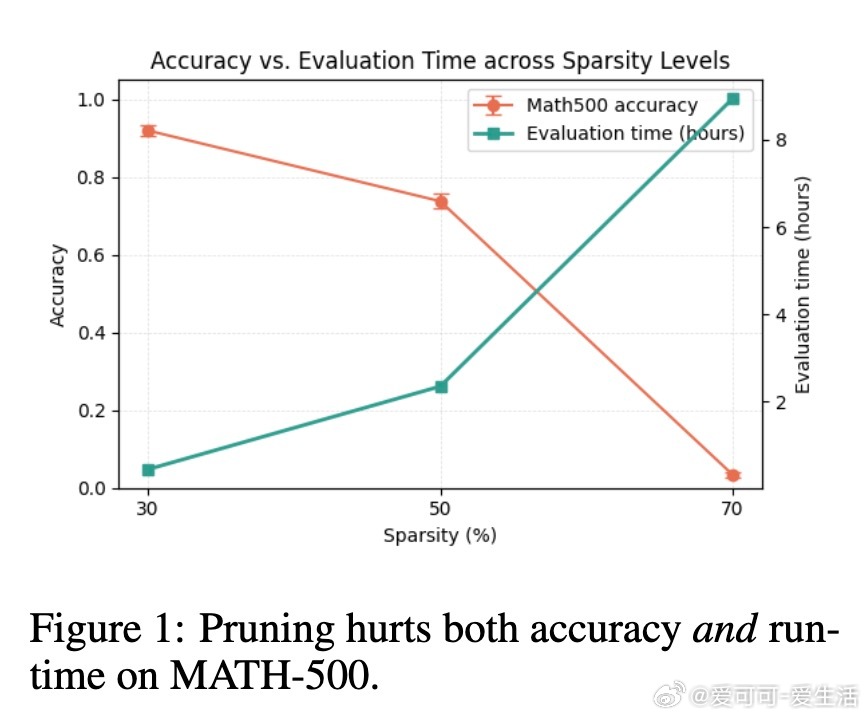

• 传统剪枝关注输入层激活,忽视推理阶段长链式思维(Chain-of-Thought, CoT)生成导致激活分布差异,造成性能与速度双重倒退。

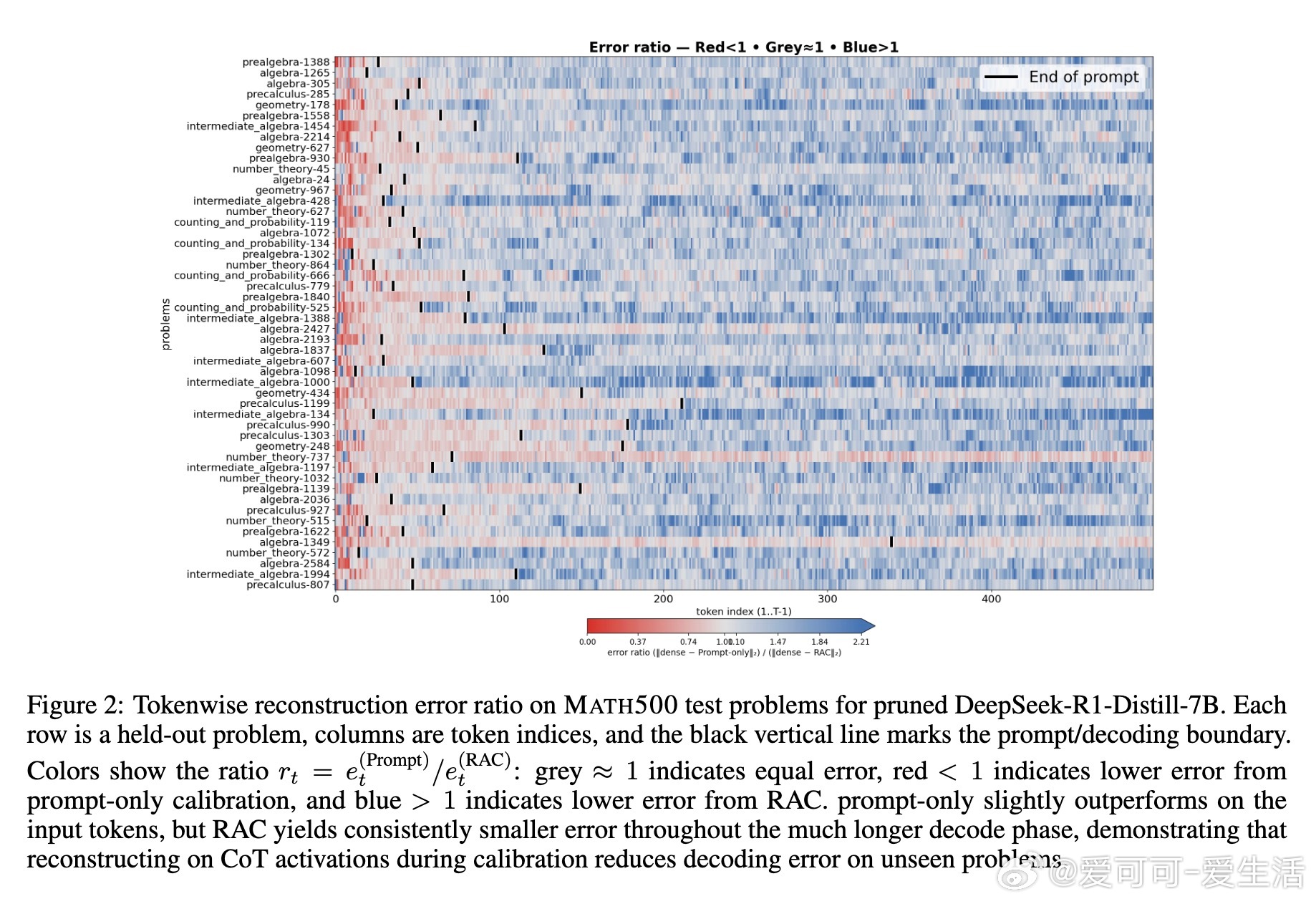

• RAC在校准时模拟推理时自回归生成的CoT激活,融合输入与推理过程激活,实质匹配推理时激活分布,实现更精准的层权重重建。

• 实验覆盖1.5B至32B参数规模的DeepSeek-R1蒸馏模型,MATH500数学推理与LiveCodeBench代码生成任务。RAC在50%剪枝率下,7B模型数学任务准确率从传统剪枝的74.4%提升至90.0%,代码生成top-16准确率也显著提高。

• RAC不仅提升推理准确率,还有效抑制剪枝后模型产生冗长且低质CoT,间接缩短推理时间,尤其在合理解码长度限制下推理效率接近密集模型。

• 方法兼容SparseGPT等主流剪枝算法,无需重训或蒸馏,简单易用,适合现实部署场景,尤其在资源受限设备和高吞吐量代理流水线中展现巨大价值。

心得:

1. 推理模型激活分布以自生成CoT为主,校准数据必须覆盖推理过程,单纯输入驱动校准难以保证剪枝质量。

2. 模型特定的推理轨迹对剪枝效果影响大,使用自身生成的激活(on-policy)优于他模型生成(off-policy)。

3. 控制合理的最大解码长度,避免过长推理链带来的推理时延激增,是剪枝后推理性能提升的关键环节。

详情🔗 arxiv.org/abs/2509.12464

大语言模型模型压缩链式思维剪枝人工智能推理能力