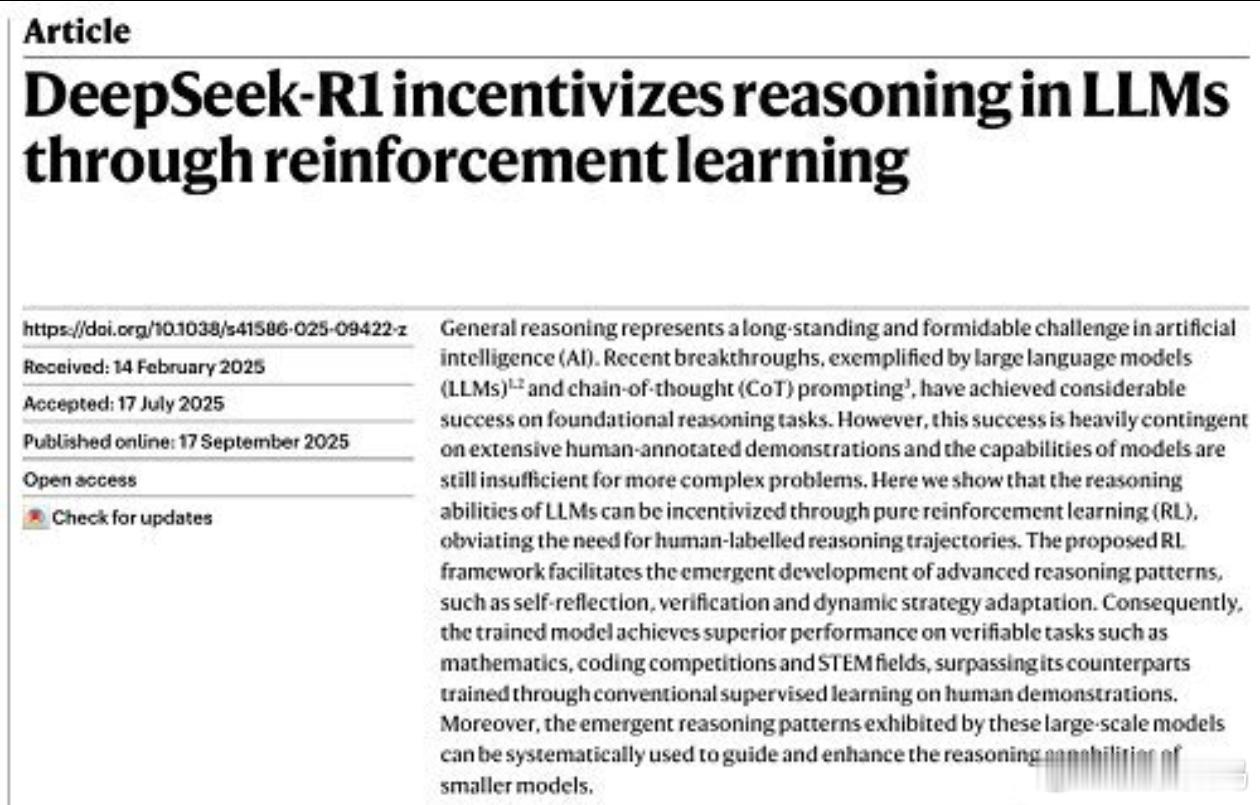

一觉醒来, 中国和全世界都沉默了, 万万没想到,梁文锋又一次刷新了世界记录。 【踏平坎坷,梁文锋的DeepSeek-R1推理模型研究论文登上国际顶级学术期刊Nature的封面】近日。 你敢信吗?这可是Nature第一次把大模型论文放上封面!更牛的是,DeepSeek-R1是全球首个闯过同行评审大关的主流大语言模型——以前那些吹得天花乱坠的AI,要么躲着不接受学术检验,要么数据偷偷摸摸不敢公开。梁文锋团队这次直接甩出64页评审文件,连训练数据里可能混了GPT-4生成内容都老老实实写清楚,这种底气在AI圈太少见了! 说出来你可能不信,这模型最狠的不是成绩多牛,是它学会了自己“刷题”。传统大模型得靠人类喂标准答案,就像小学生抄作业;但DeepSeek-R1靠“纯强化学习”自己试错,做对题就给奖励,做错了就复盘,活生生把数学基准测试分数刷到79.8%,比GPT-4高出一大截 。团队里的工程师说,为了调那个“奖励模型”参数,梁文锋带着大伙在服务器机房连续熬了48小时,监控屏上跳动的损失值比股票K线还让人揪心。这种让AI自己进化的思路,直接把训练成本砍到了29.4万美元,连OpenAI零头都不到! 别以为这是小打小闹,Nature用“里程碑”三个字评价这事,背后藏着大学问。你知道吗?现在AI圈吹牛皮成风,好多模型号称“超越人类”,结果连基本的逻辑题都做不对。梁文锋偏不搞这套,主动要求最严格的同行评审——评审专家拿着放大镜挑了半年毛病,从数据污染到推理漏洞问了个遍。团队硬是一条条改,把拟人化描述全删了,还公开了去污染措施的代码。这种较真劲儿,难怪论文一发表,Hugging Face上的下载量直接冲破1090万次,全球研究者都疯了似的扒代码学习! 最让人叫绝的是它的“性价比”。别人训练个大模型动辄烧几十亿美元,梁文锋团队用600多万美元就搞定了全套研发。秘诀就在那个GRPO算法上,不用复杂的批判模型,靠群体优势估计就能优化推理策略,相当于让AI自己当自己的老师。效果呢?在数学竞赛题上,R1-Zero版本拿了71%的正确率,直接追平OpenAI的顶级模型O1。更妙的是开源策略,现在全世界开发者都能用它的22万条推理数据训练小模型,这才是真的把技术门槛给砸矮了! 当然质疑声也没断过。有人说“开源会不会泄露核心技术”,但梁文锋团队早想明白了——最新的V3.1版本都用上混合推理架构了,模型能自己决定啥时候该深入思考,啥时候该快速回答,这种动态调整能力,靠抄代码根本学不会。还有人揪着“数据里有GPT-4痕迹”不放,可人家早就声明是无心之失,还加了专门的过滤机制,这种坦荡可比某些藏着掖着的大厂强多了! 这事儿最打动人的,是它打破了“AI研究只能靠烧钱”的迷信。梁文锋团队证明了,只要方法对路,小团队也能做出世界级成果。现在全球AI圈都在讨论,这种“纯强化学习+严格评审”的模式会不会成为新规矩?那些靠PPT融资的伪创新,以后怕是混不下去了。 各位读者你们怎么看?欢迎在评论区讨论。