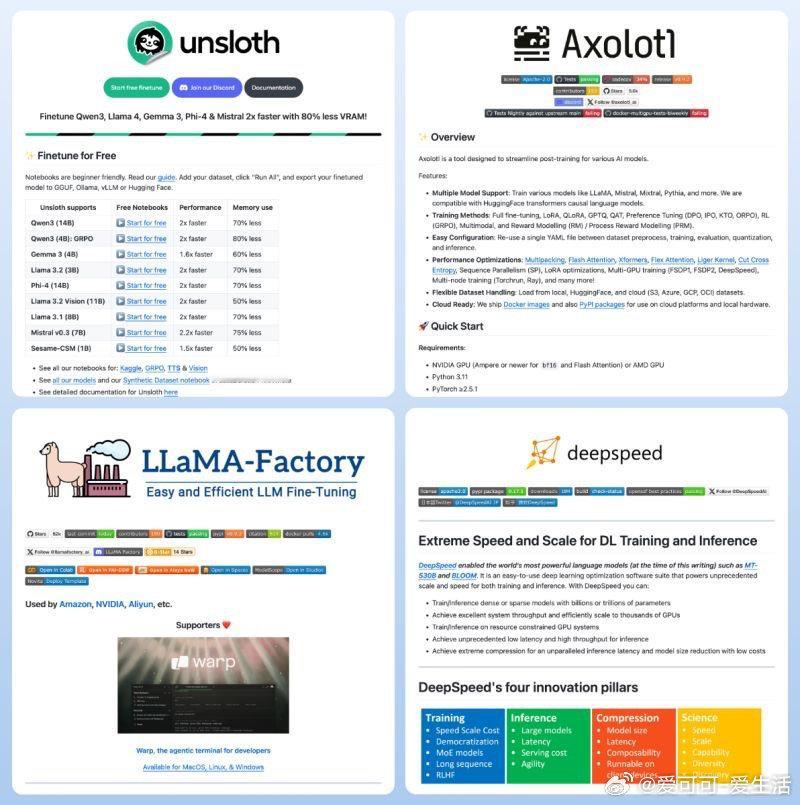

开源大模型微调库的最新格局,四大热门方案,助力高效定制与训练优化。

• UnsloTh:免费友好,支持Qwen3、Llama4、Phi-4等主流模型,2倍速微调且显存占用降低至50%-80%,集成Kaggle、GRPC等多平台笔记本,入门门槛极低,适合快速迭代与导出至GGUF、Hugging Face生态。

• Axolotl:针对多模型后训练优化,兼容LLaMA、Mistral、Pythia等,支持多种训练任务(如SFT、RLHF、奖励建模),配置简洁通过YAML文件完成,性能优化涵盖多种加速技术(Flash Attention、Liger Kernel等),且支持主流云平台与本地硬件灵活部署。

• LLaMA-Factory:亚马逊、NVIDIA等巨头背书的高效微调工具,定位“易用且高效”,强调适配大规模分布式训练,支持Aliyun等云环境,配套Warp终端工具提升开发体验,适合追求工业级稳定与扩展性的团队。

• DeepSpeed:微软出品,专注极致训练与推理性能,支持数十亿至万亿参数模型,优化GPU资源利用率,低延迟高吞吐,压缩模型尺寸降低成本,创新涵盖训练速度、推理延迟、模型压缩及科学探索,适合追求极限性能的深度学习研发。

心得:

1. 微调效率与显存优化的双重突破,释放了更多模型潜力,降低了硬件门槛。

2. 配置自动化与灵活部署成为趋势,推动多云多端一体化生产环境的普及。

3. 训练与推理的深度融合,促使模型开发进入“训练-推理-压缩”闭环,提升整体应用价值。

详见🔗github.com/unslothai/unsloth | github.com/axolotl-ai-cloud/axolotl | github.com/hiyouga/LLaMA-Factory | github.com/microsoft/DeepSpeed

大模型 开源 微调 深度学习 AI训练