人形机器人上麻将桌!北京创企攻克30分钟自主对战难题,翻牌碰杠比人还流畅

作者 |许丽思

编辑 |漠影

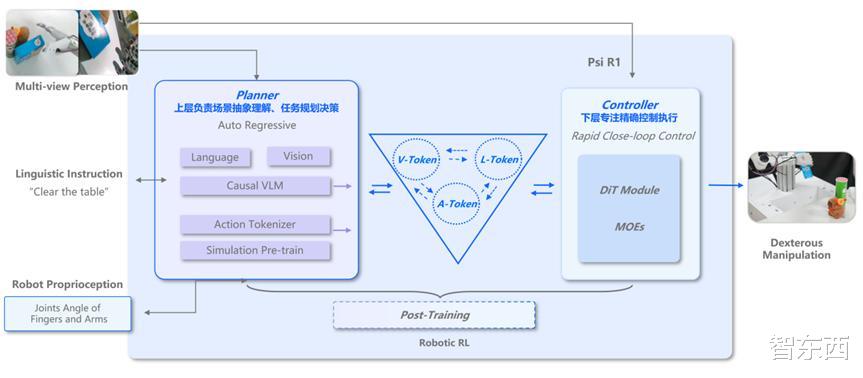

机器人前瞻4月27日报道,今天,灵初智能发布了分层端到端VLA+强化学习算法模型Psi-R1。R1能够让机器人基于Chain of Action Thought(CoAT)框架的自主推理系统,在开放环境下进行自主推理决策,完成长程复杂操作。

R1以麻将为场景,展现了机器人在开放环境中的长程灵巧操作能力,达成了30分钟+持续CoAT超长任务时长,还验证了三重复合交互能力,即人-机交互、机-机交互、机-环境交互。

机器人要学会打麻将,难在哪?

机器人需要理解麻将的规则,确保行为符合游戏规则。

机器人还需要制定合理的策略,如根据手牌状态、牌局演变以及对手行为来完成动态策略生成,决定出牌、吃碰杠等操作,涉及大量人机交互、机机交互等动作。

机器人操作需要完成毫米级精度的抓牌、出牌、理牌等灵巧精细动作,这对机器人的长程任务规划、灵巧操作能力提出了巨大挑战。

在视频中,R1让机器人具备了翻牌、碰杠、算牌、协作等核心能力。可以看到,机器人灵巧手攻克了触觉-视觉模态对齐难题,实现100%准确翻起麻将牌。

机器人能够根据牌友的出牌,构建牌局状态机,自主构建碰、杠等策略链,并丝滑地完成碰杠动作。

在长程规划上,机器人能够记得所有人打过的所有的牌,并根据牌桌状况动态规划要打的牌。

两台机器人甚至还会相互配合,不仅仅信息共享,互相“看牌”,还能多机配合递牌,提升胜率。

不同于Pi,Figure等「动作单向决策」机制的VLA模型(仅能完成视觉-语言层面的CoT),灵初智能的R1模型的慢脑输入包括行动Token,构建了首个支持「动作感知-环境反馈-动态决策」全闭环的VLA模型,实现机器人操作的视觉-语言-动作多模态协同的CoAT思维链,且已首度成功验证VLA Test-Time Scaling。

慢脑S2专注于推理规划,S1的操作经过tokenize后,作为S2慢脑的输入,和语言、视觉模态融合,基于Causal VLM自回归架构,实现多模态融合的推理和任务规划。

快慢脑通过Action Tokenizer隐式连接,端到端训练,协同完成长程任务的灵巧操作。

灵初智能R1可以应用于多个场景中,例如泛工业中来料仓检测、成品包装等场景,零售物流中拣选、分拨、补货、打包等场景,以及家庭服务与协作场景。

目前,该公司已与制造业、商超零售、跨境物流等行业龙头企业展开合作,梯次布局高价值商业化场景,从泛工业向泛零售物流,再最终迈向家庭应用。