[LG]《Strategy Coopetition Explains the Emergence and Transience of In-Context Learning》A K Singh, T Moskovitz, S Dragutinović, F Hill... [University College London & Anthropic AI & University of Oxford] (2025)

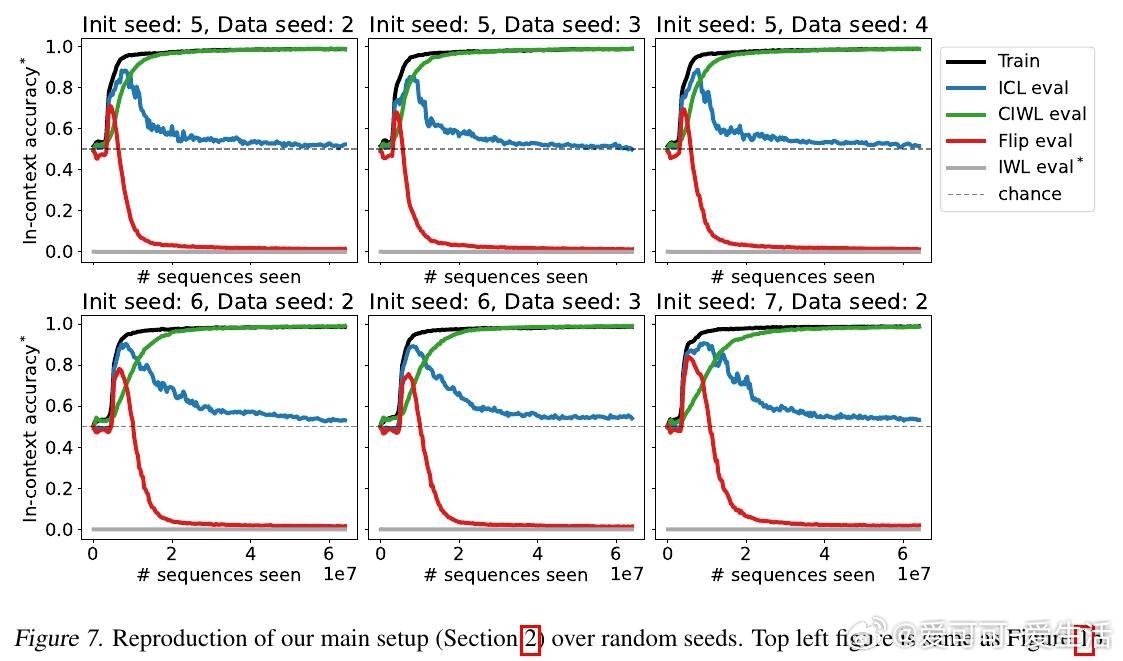

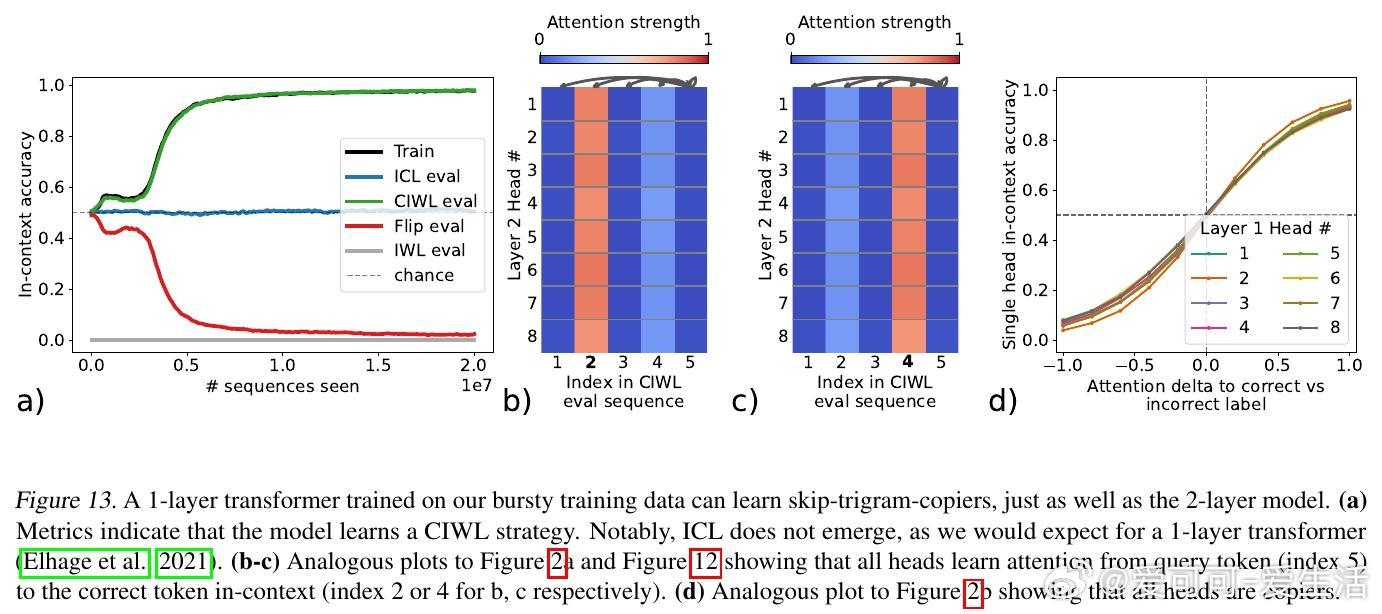

Transformer模型中,in-context learning(ICL)的出现与消失背后隐藏着复杂的“策略合作竞争”机制。该研究通过小型注意力网络和合成任务,揭示了ICL与一种新型“上下文约束的in-weights学习”(CIWL)策略的动态共存与替代过程,推动了对模型学习策略演变的理解。

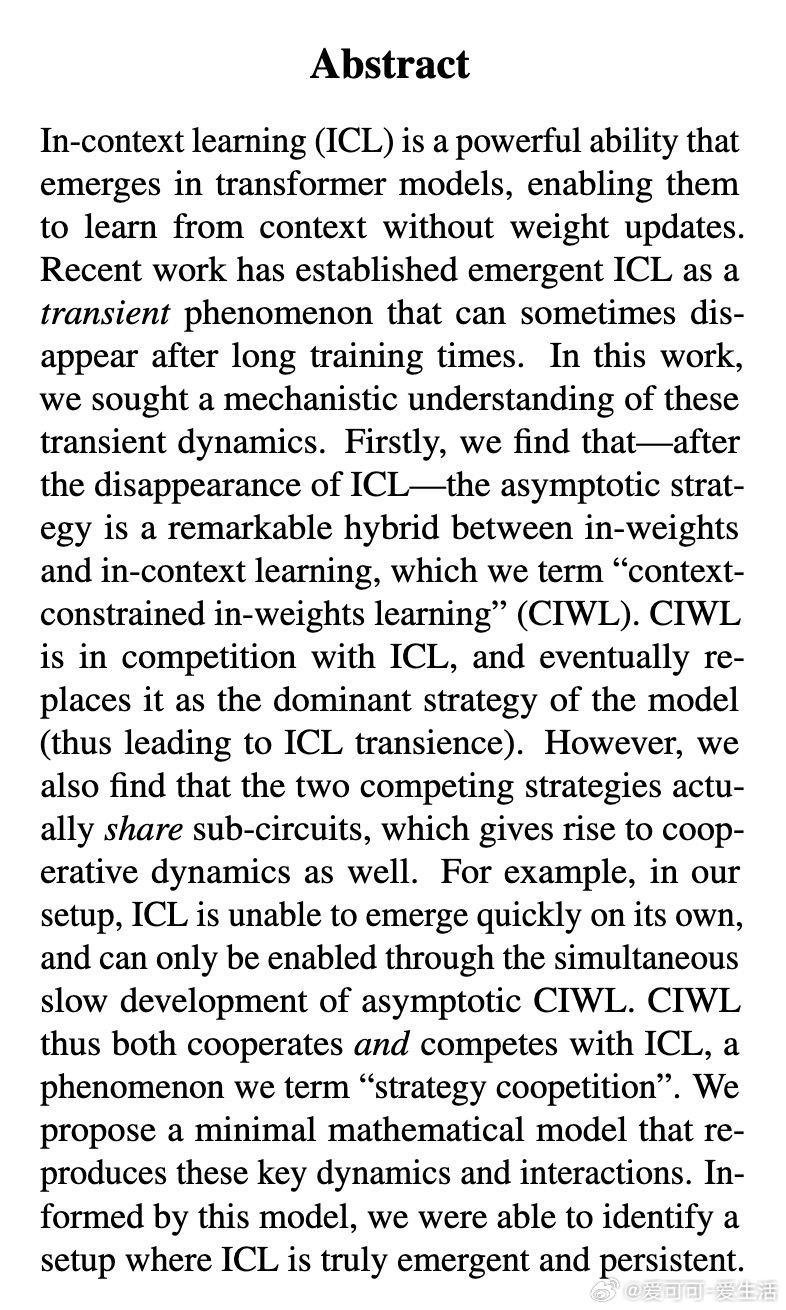

• ICL能力使模型能在推理时根据上下文快速适应,无需权重更新,表现为“快速但非持久”的策略。

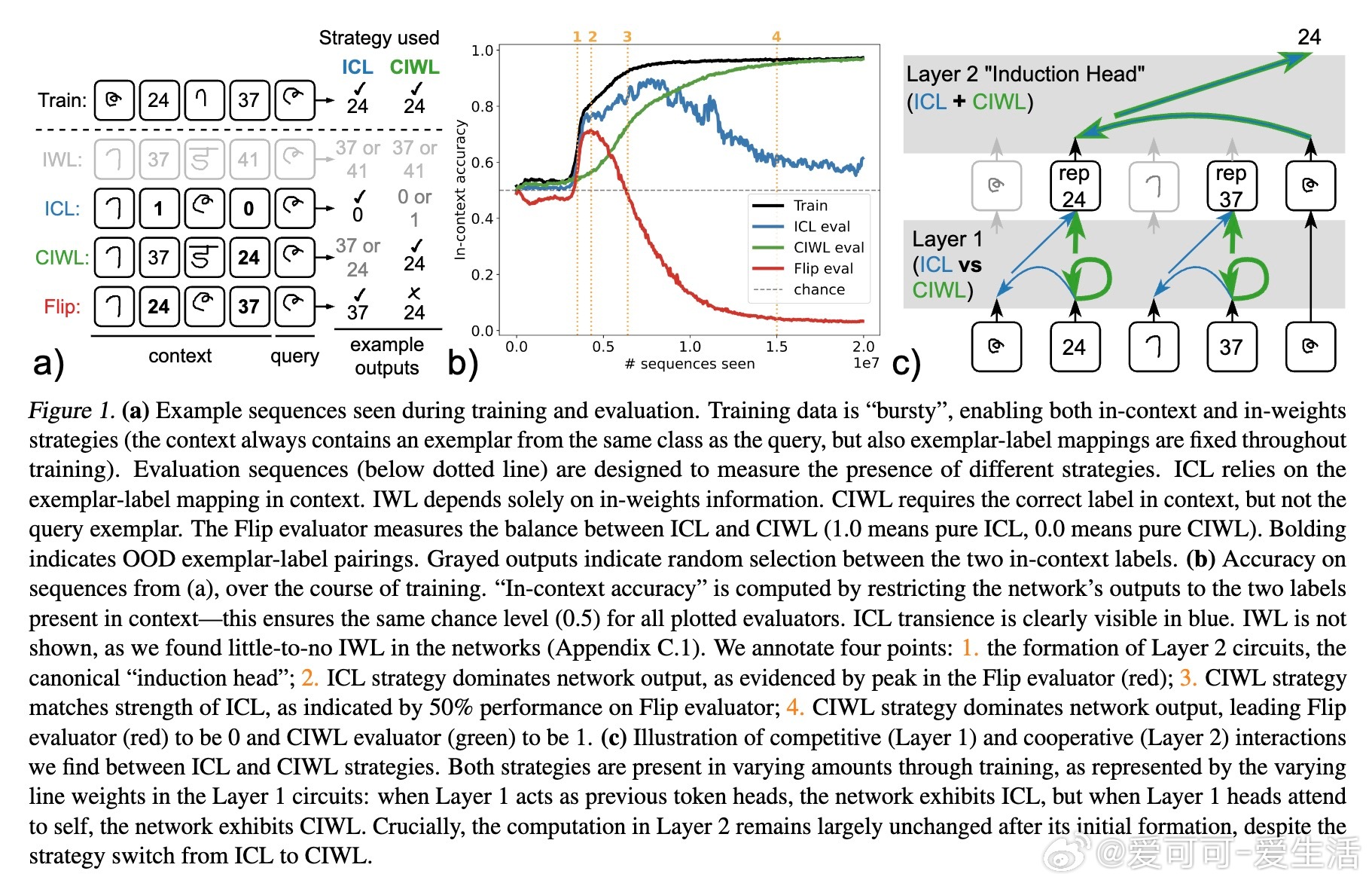

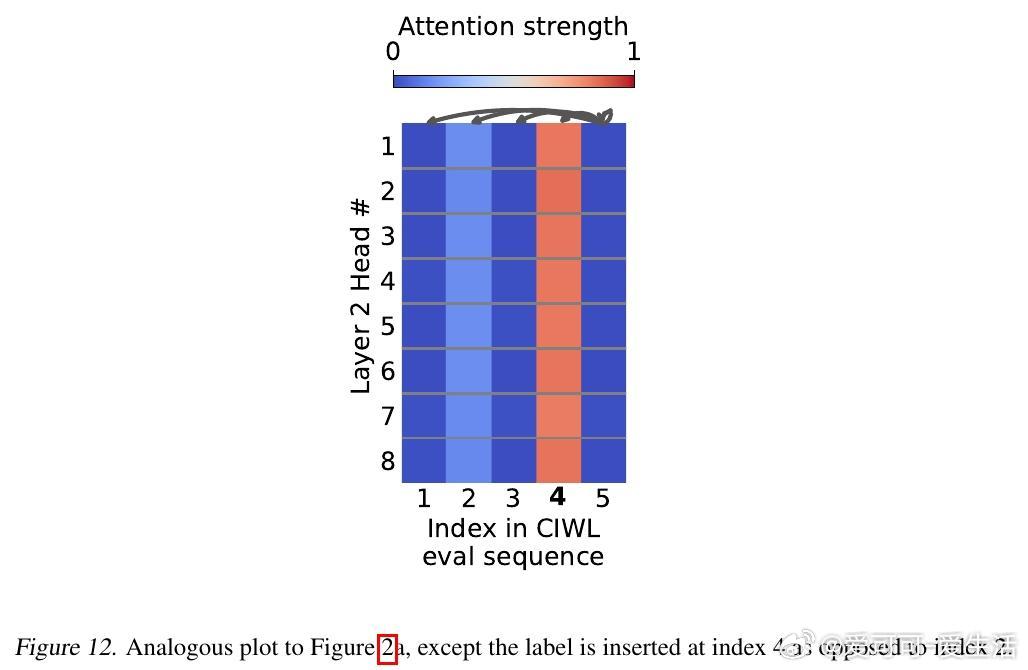

• CIWL融合了上下文信息与权重学习,通过Layer 2的skip-trigram机制实现,成为训练后期的优势策略。

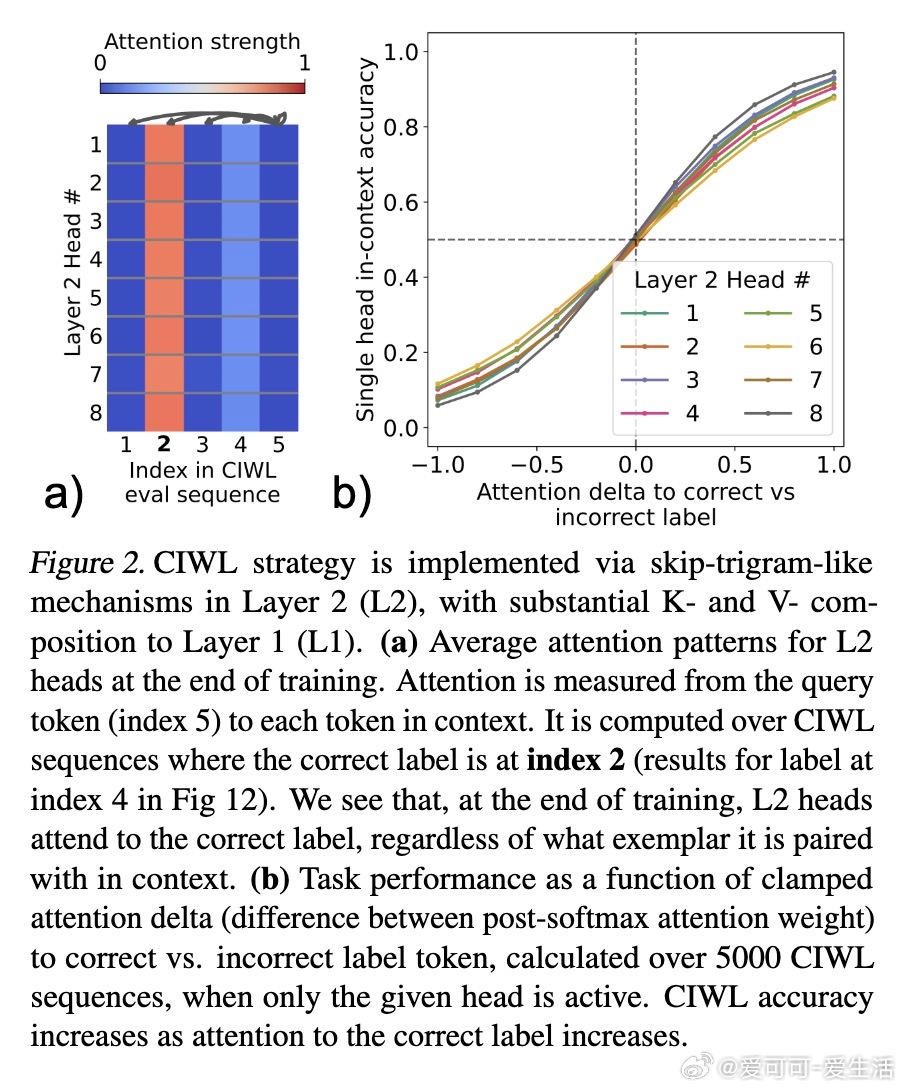

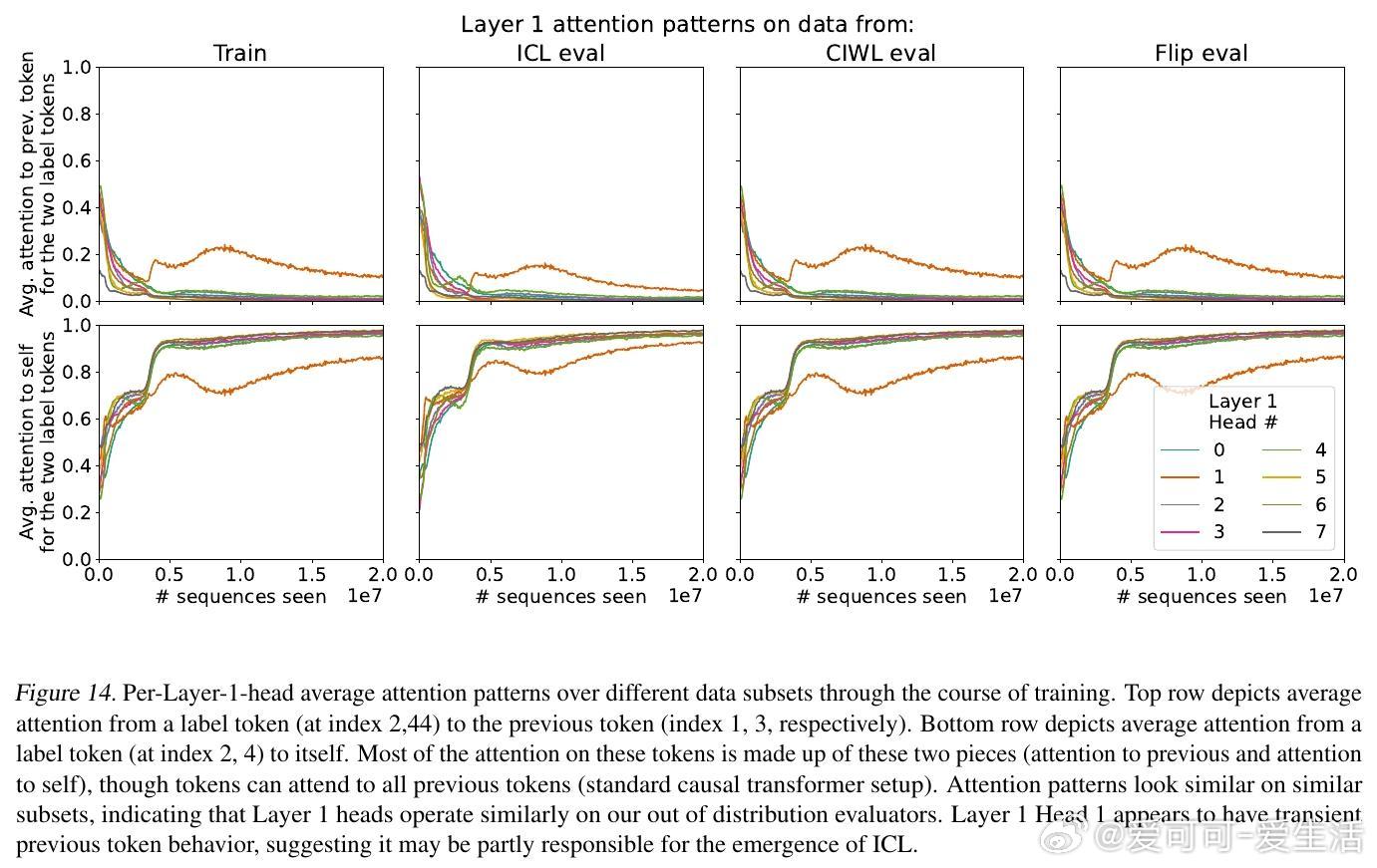

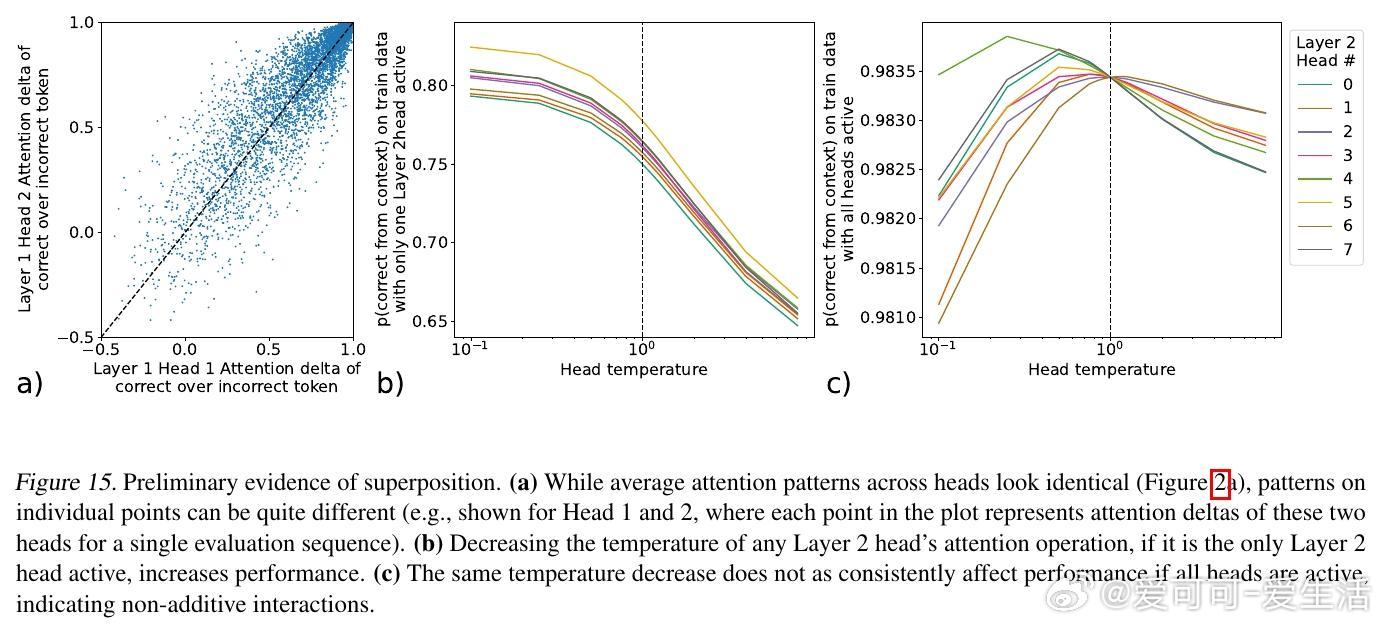

• 两种策略共享关键子电路,Layer 2表现合作,Layer 1表现竞争,形成“coopetition”——既合作又竞争的共生关系。

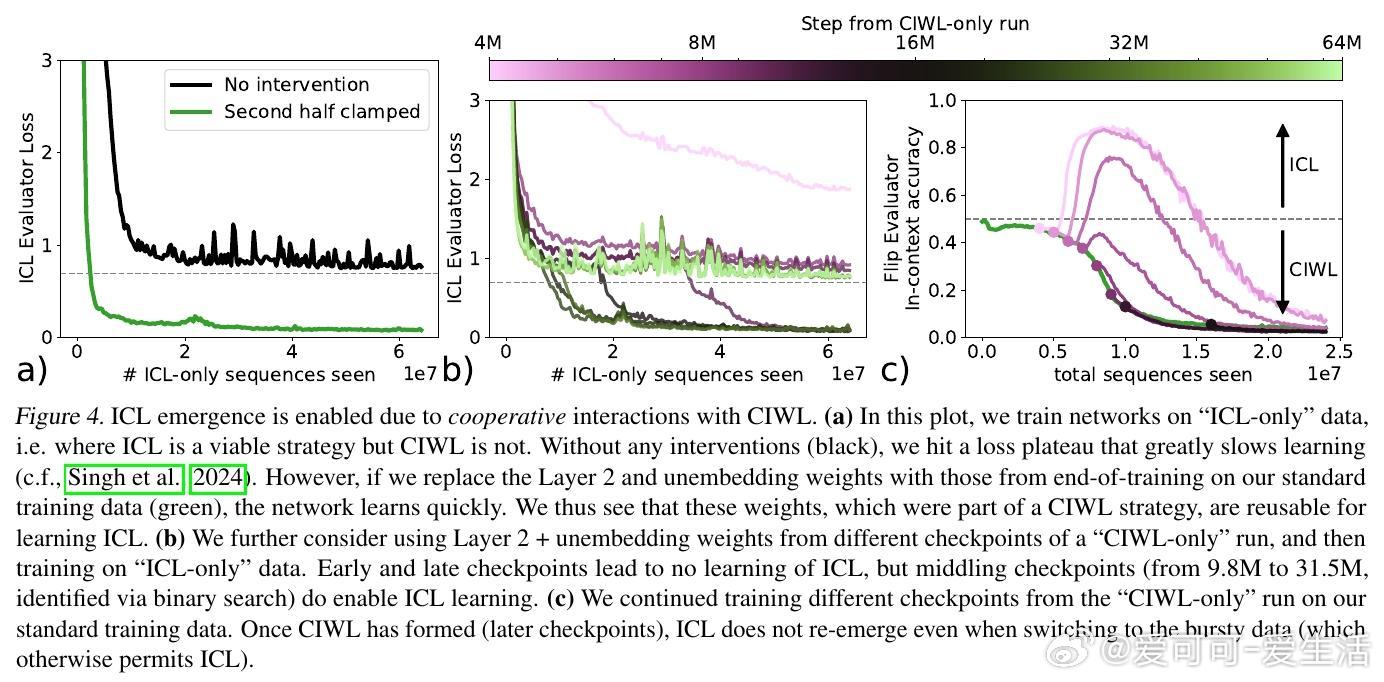

• ICL的出现依赖于CIWL的部分形成,且CIWL成熟后ICL消退,解释了ICL的短暂性现象。

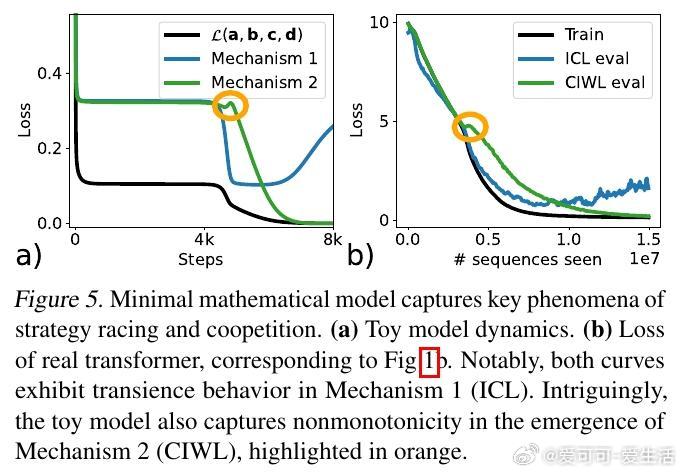

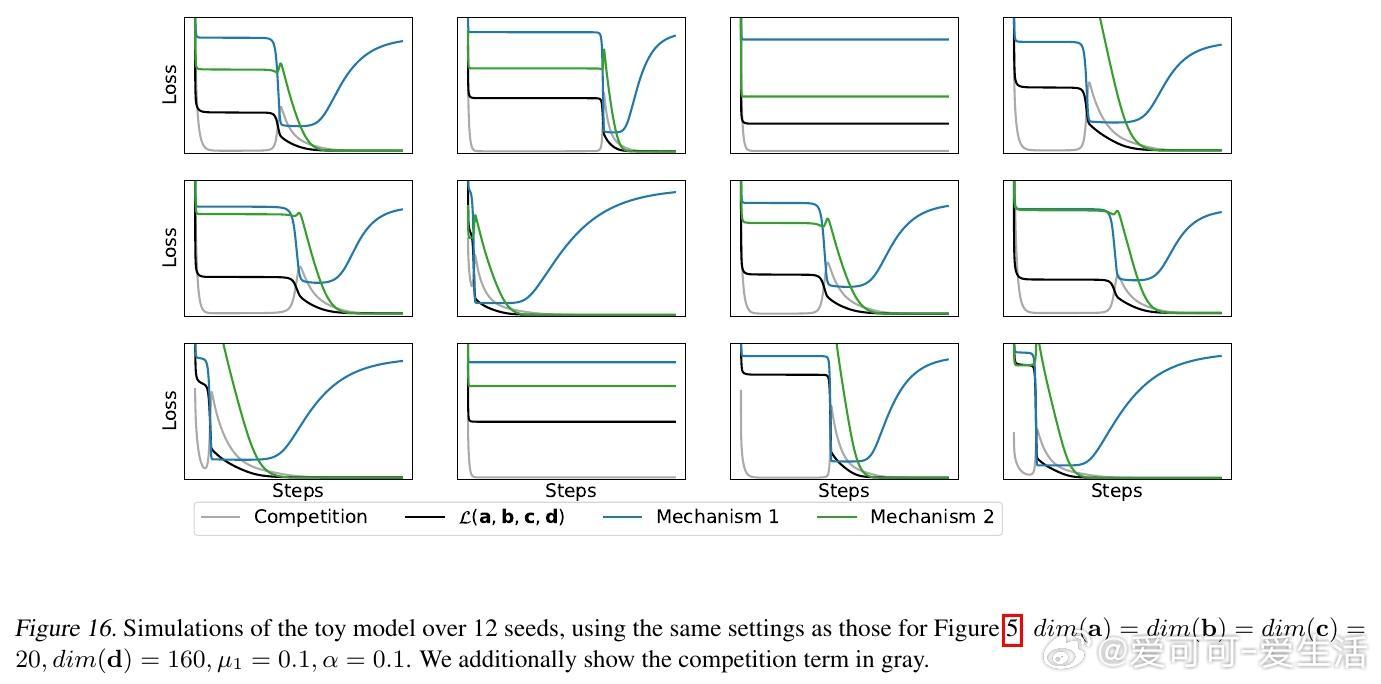

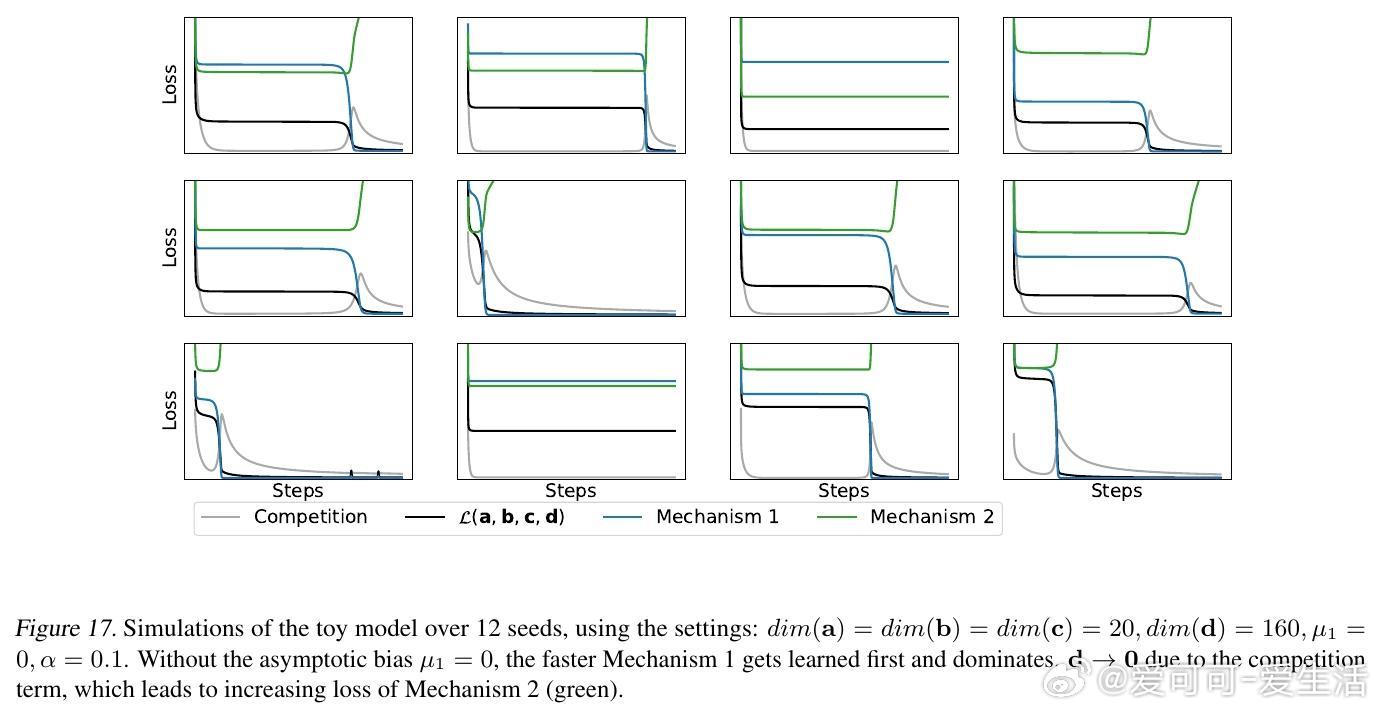

• 通过数学模型刻画策略竞速与合作现象,验证了策略间的相互依赖与冲突导致的训练动态。

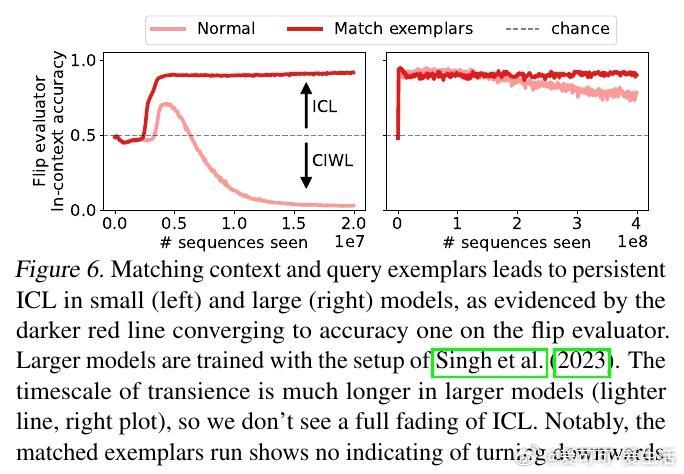

• 数据特性(如上下文示例与查询示例的匹配)可调节ICL的持久性,匹配增强ICL,打破其转瞬即逝的规律。

• 该发现对理解多策略共存、能力涌现及消退提供了新视角,有助于未来设计更稳定高效的上下文学习机制。

心得:

1. 模型策略非静态,训练过程中的策略切换可能是性能演变的关键,单一时间点的观察易导致误判。

2. 共享子电路的策略既相互促进又相互抑制,揭示了复杂网络内部协同与竞争并存的深层机制。

3. 适当设计数据分布可“引导”模型策略,提升持续的上下文适应能力,为训练范式创新提供理论支撑。

详见🔗openreview.net/forum?id=esBoQFmD7v

人工智能大模型机器学习Transformer上下文学习模型机制策略竞赛ICLCIWL