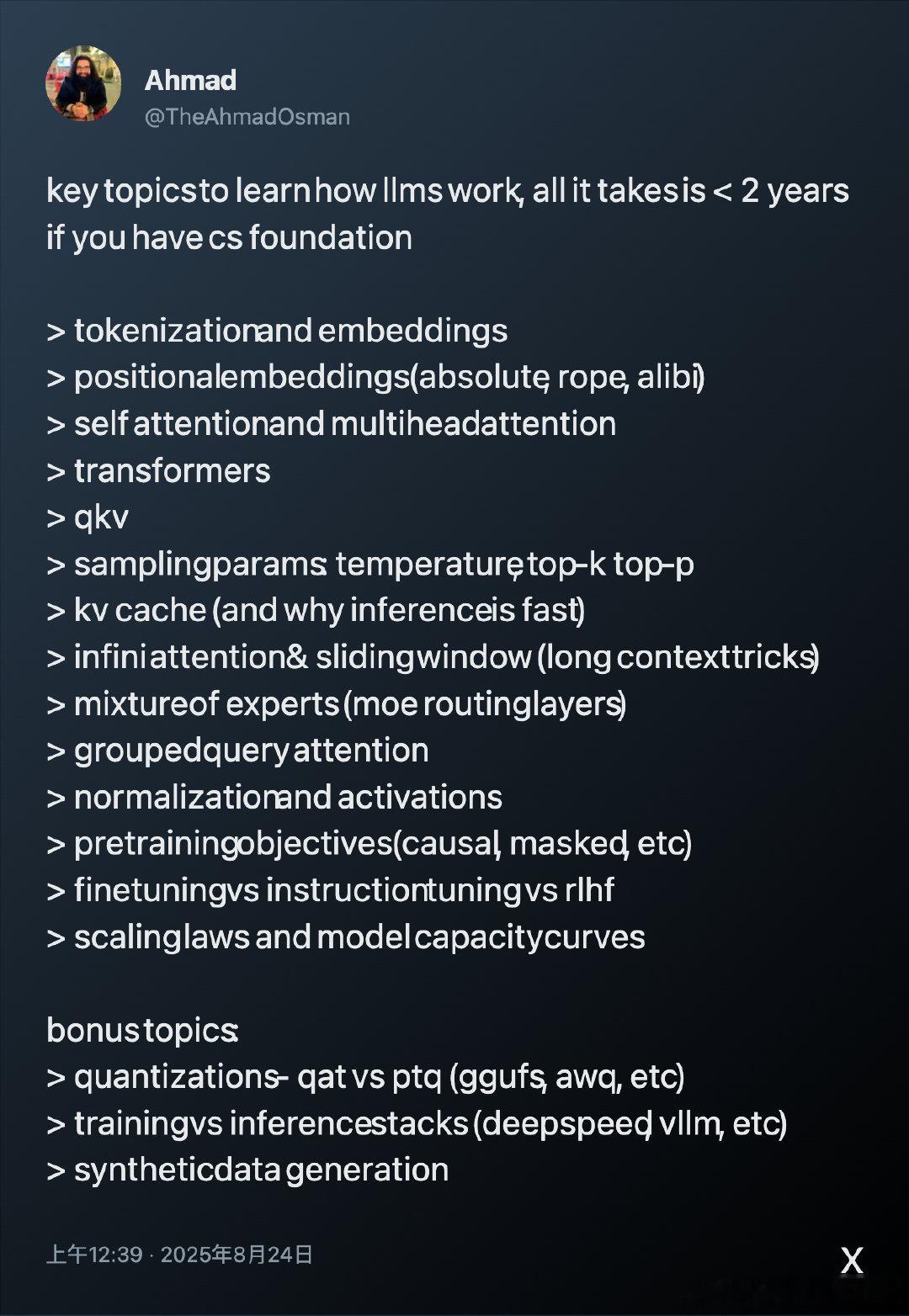

掌握大型语言模型(LLM)运作核心,具备计算机科学基础者,2年内可系统化精通:

• Tokenization 与 embeddings:理解文本转化为向量的第一步

• 位置编码(绝对、RoPE、Alibi):模型感知序列顺序的关键技术

• 自注意力与多头注意力机制:捕捉长距离依赖的底层结构

• Transformer 架构及 QKV 机制:现代 NLP 模型的基石

• 采样参数(temperature、top-k、top-p):控制生成文本多样性和质量

• KV Cache 原理:推理加速的核心秘密

• 长上下文处理技巧(infinite attention、sliding window):突破输入限制

• Mixture of Experts(MoE 路由层)和 Grouped Query Attention:提升模型效率与容量

• 归一化与激活函数:稳定训练与表达能力的保障

• 预训练目标(causal、masked 等)与微调流程(finetuning、instruction tuning、RLHF):模型能力塑造的关键环节

• 规模定律与模型容量曲线:性能提升的数学规律

附加进阶:

• 量化技术(QAT vs PTQ,GGUF、AWQ 等):减少模型体积与计算成本

• 训练与推理堆栈(DeepSpeed、vLLM 等):高效使用硬件资源

• 合成数据生成:扩展训练数据的新途径

深入理解这些内容,不仅能快速掌握 LLM 工作机制,还能在实践中有效优化与创新。

🔗 x.com/TheAhmadOsman/status/1959294477119467734

大型语言模型 机器学习 自然语言处理 人工智能 深度学习