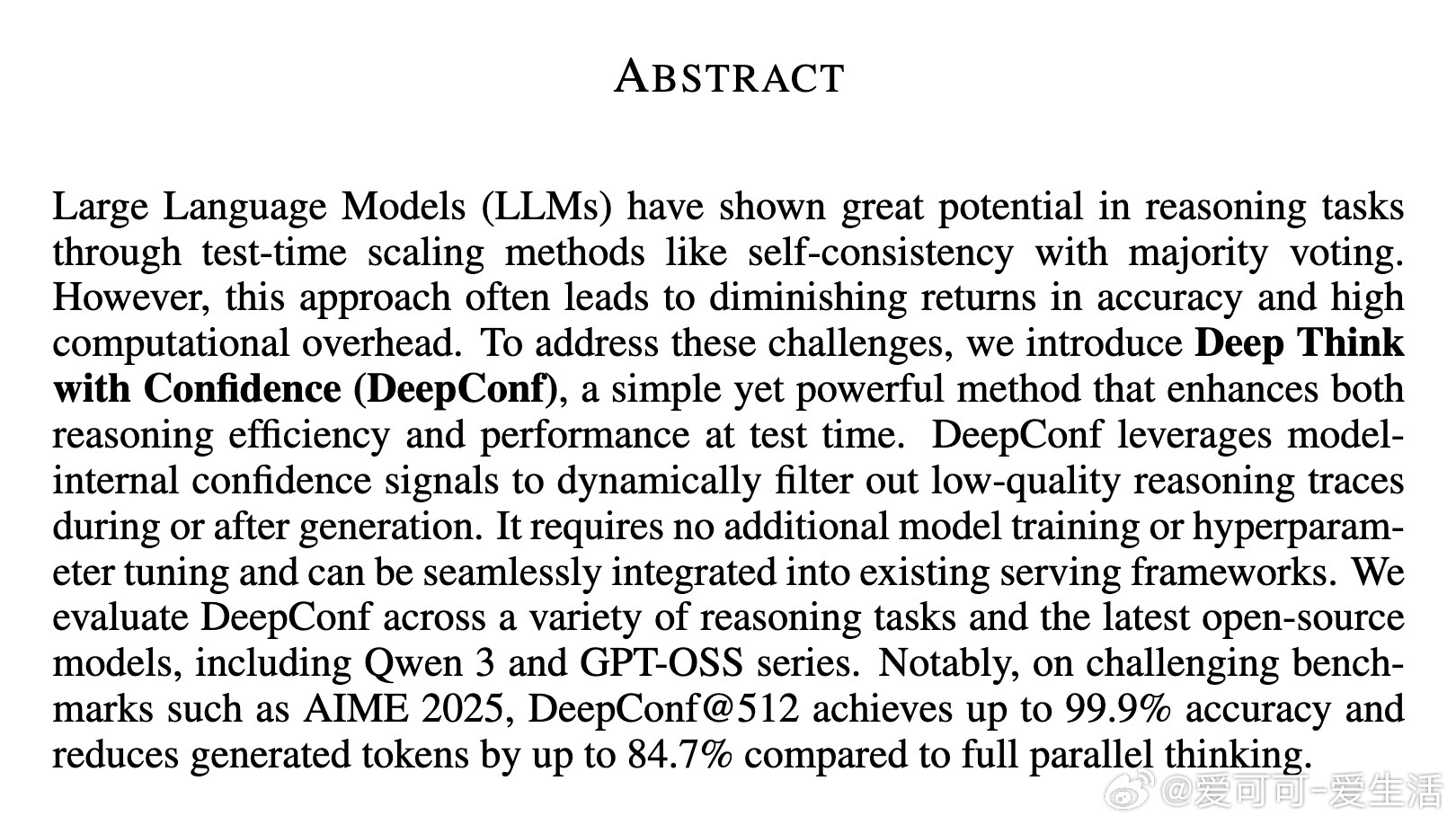

[LG]《Deep Think with Confidence》Y Fu, X Wang, Y Tian, J Zhao [Meta AI & UCSD] (2025)

DeepConf:提升大语言模型推理效率与准确性的全新方法

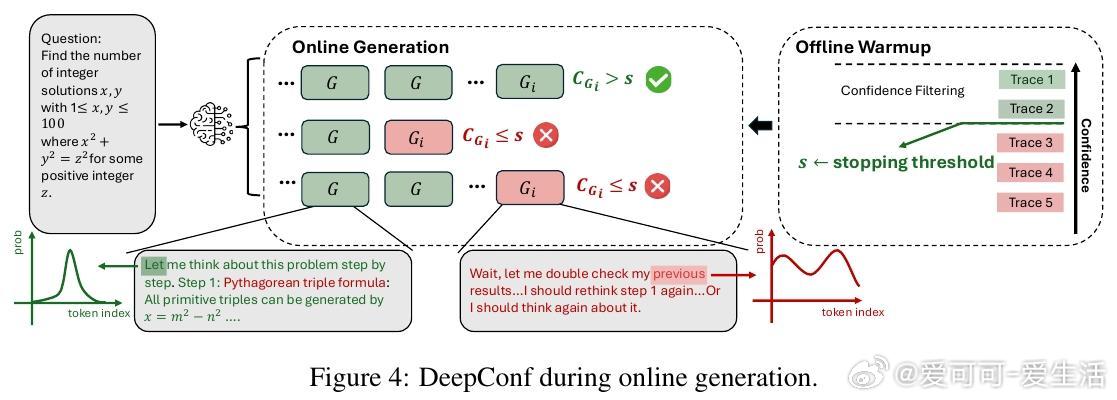

• 针对传统自洽法(self-consistency)计算资源消耗大、准确率提升有限的问题,DeepConf利用模型内部的局部置信度信号,动态筛选和提前终止低质量推理路径。

• 无需额外训练或超参数调优,可无缝集成于现有推理框架,实现推理质量与效率的双重提升。

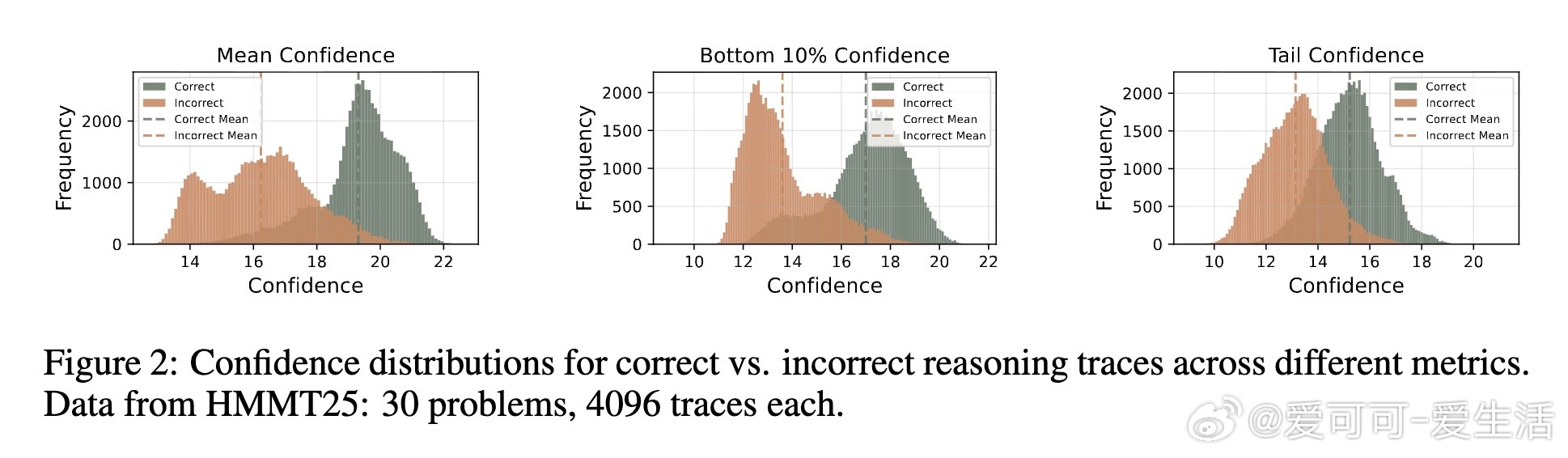

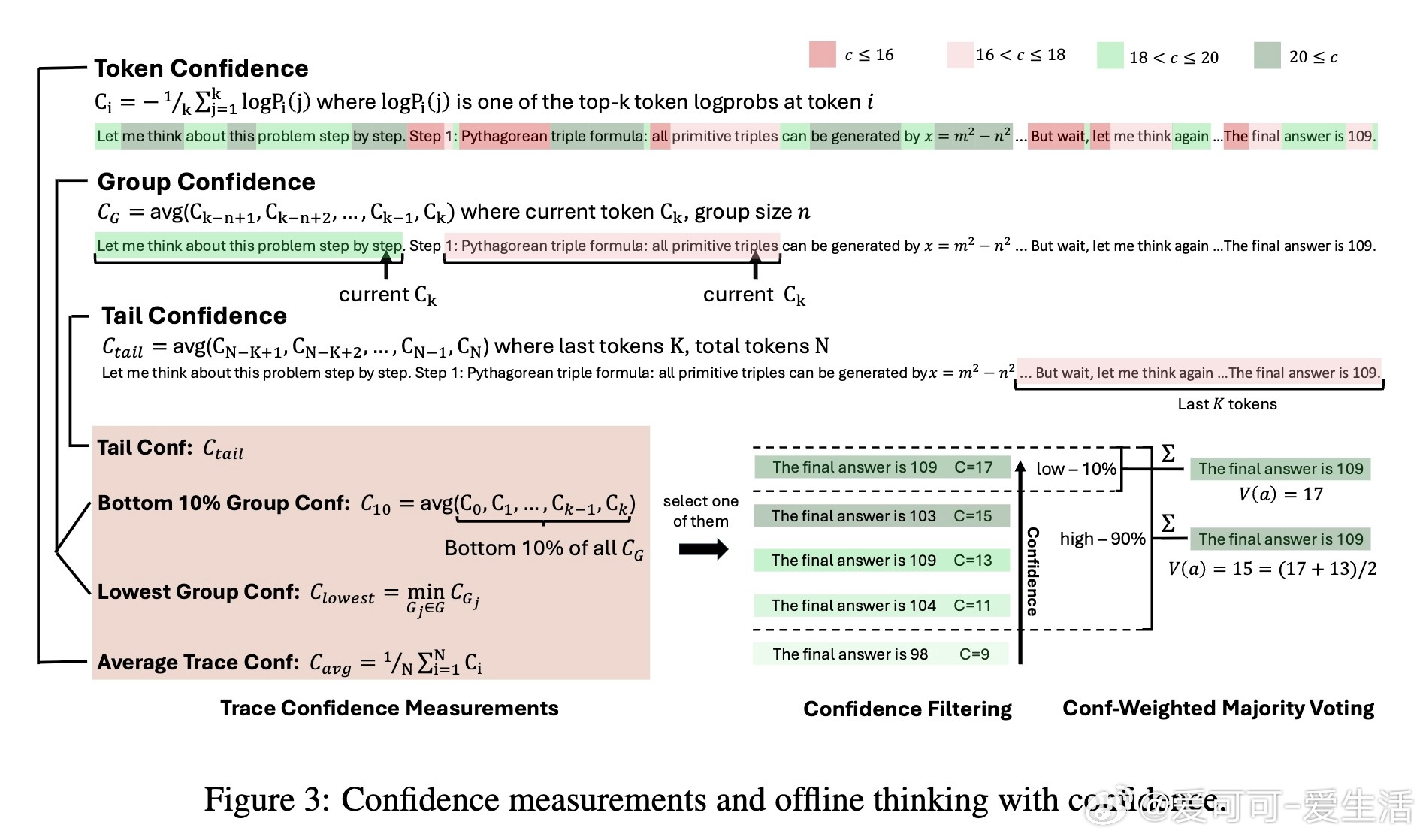

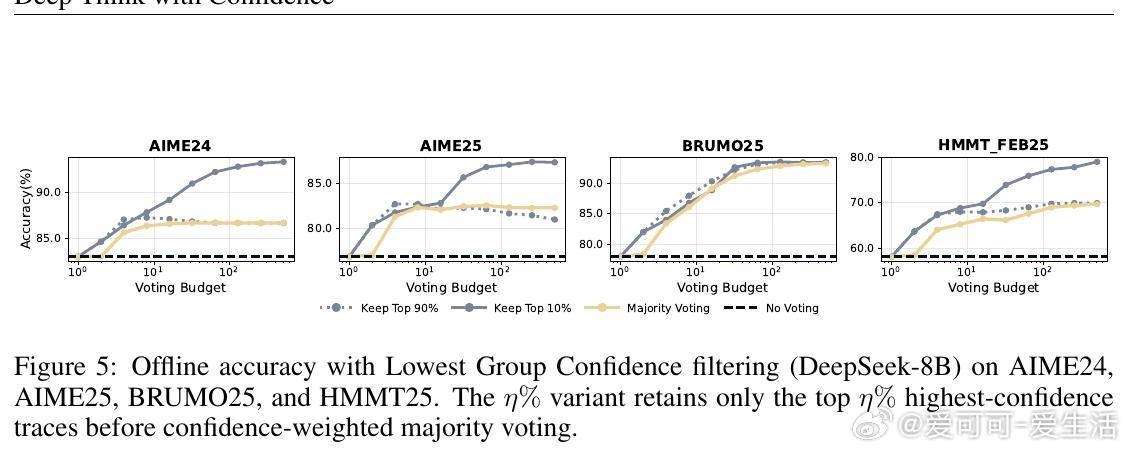

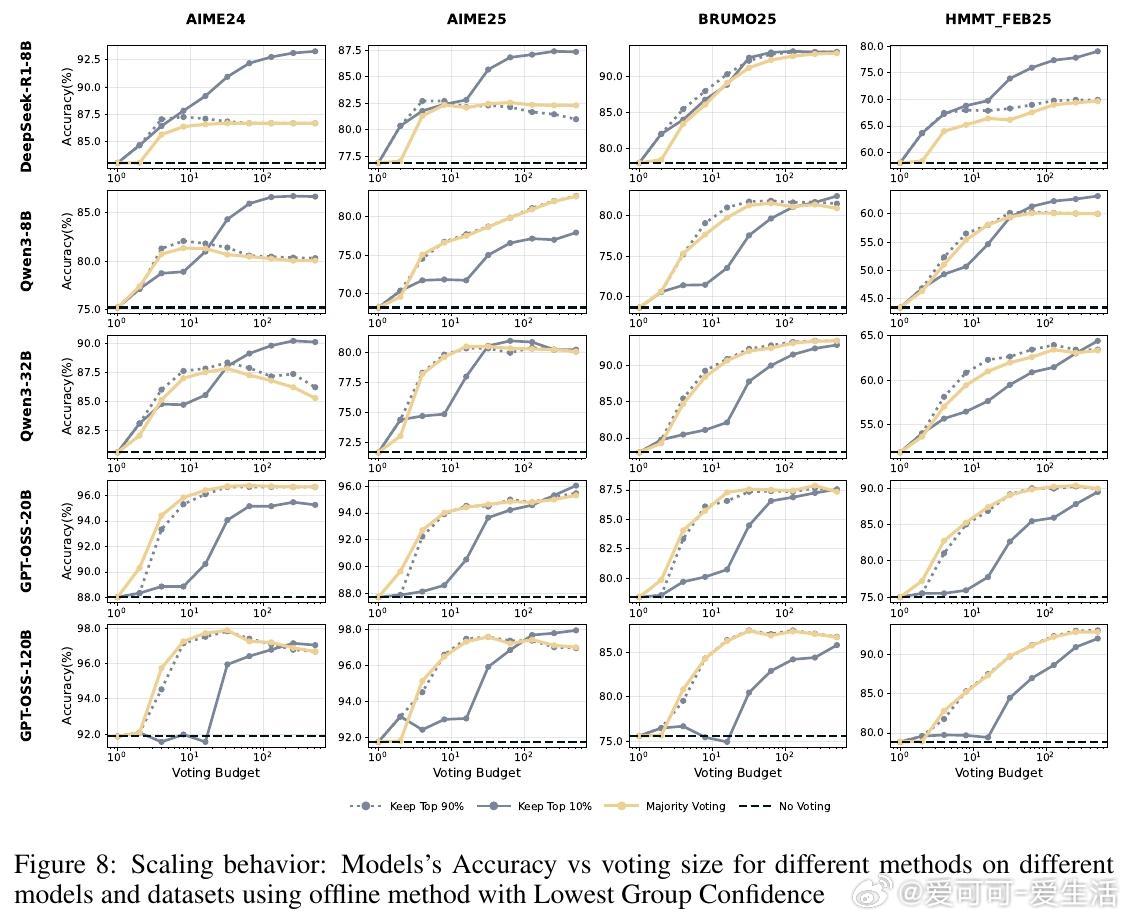

• 采用多样化置信度度量:组置信度、尾部置信度、最低组置信度等,精准捕捉推理过程中关键步骤的质量波动。

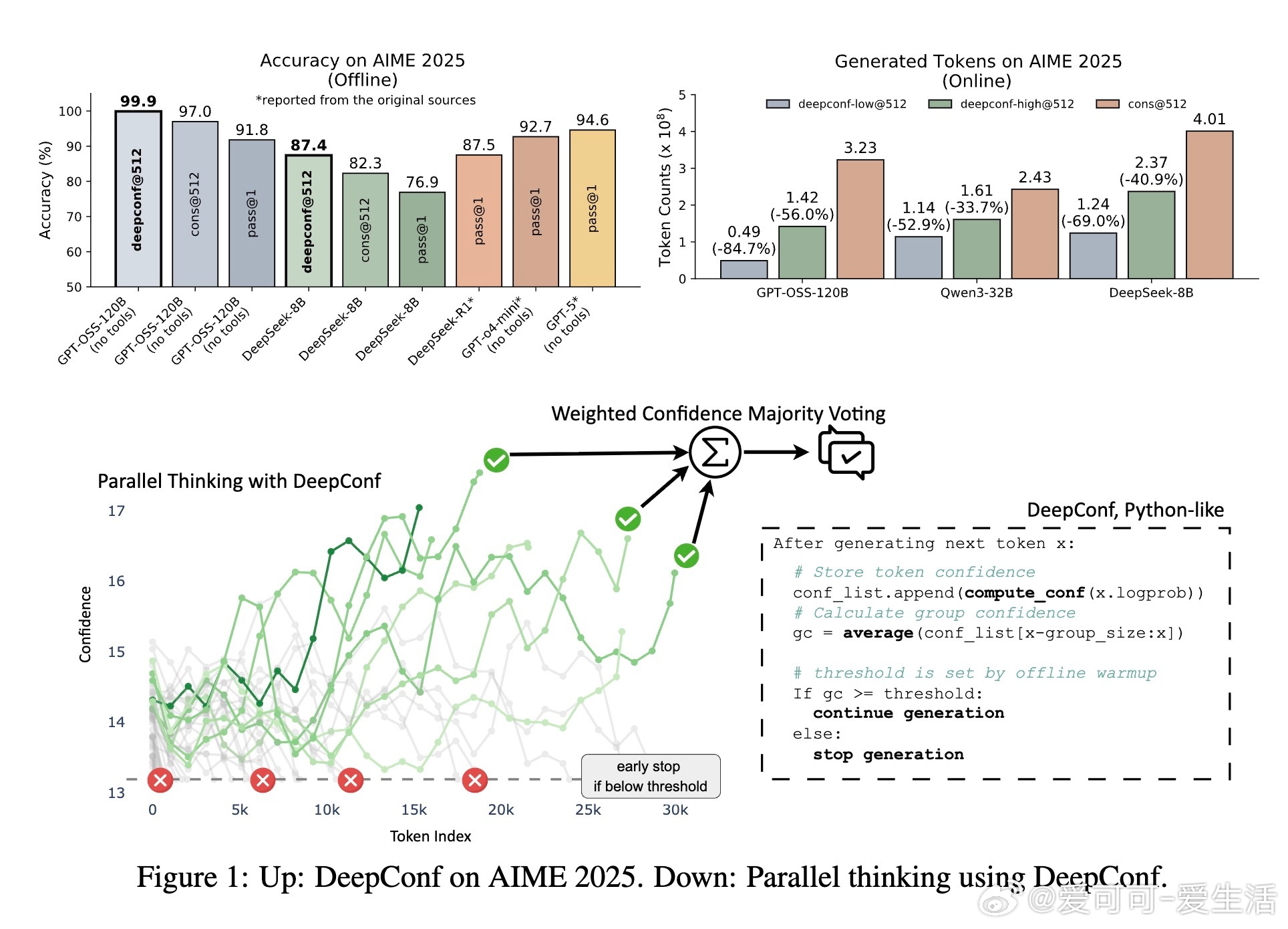

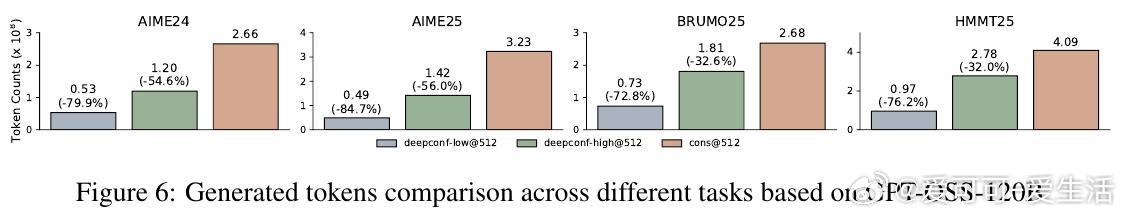

• 在AIME2025等高难度数学推理基准测试中,使用GPT-OSS-120B模型,DeepConf

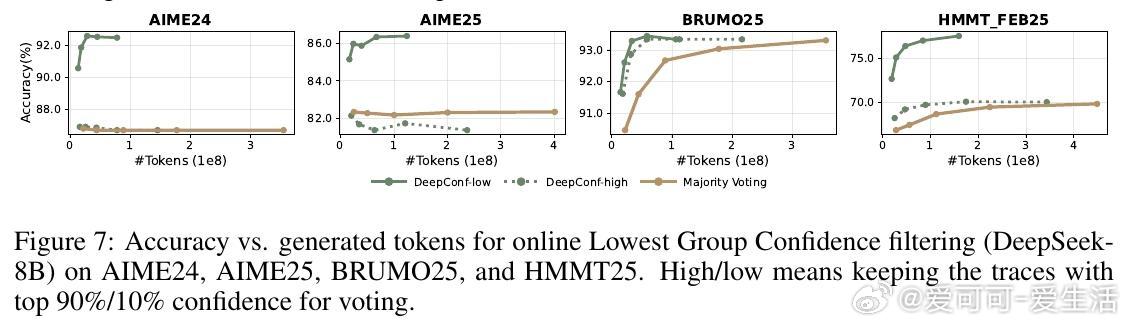

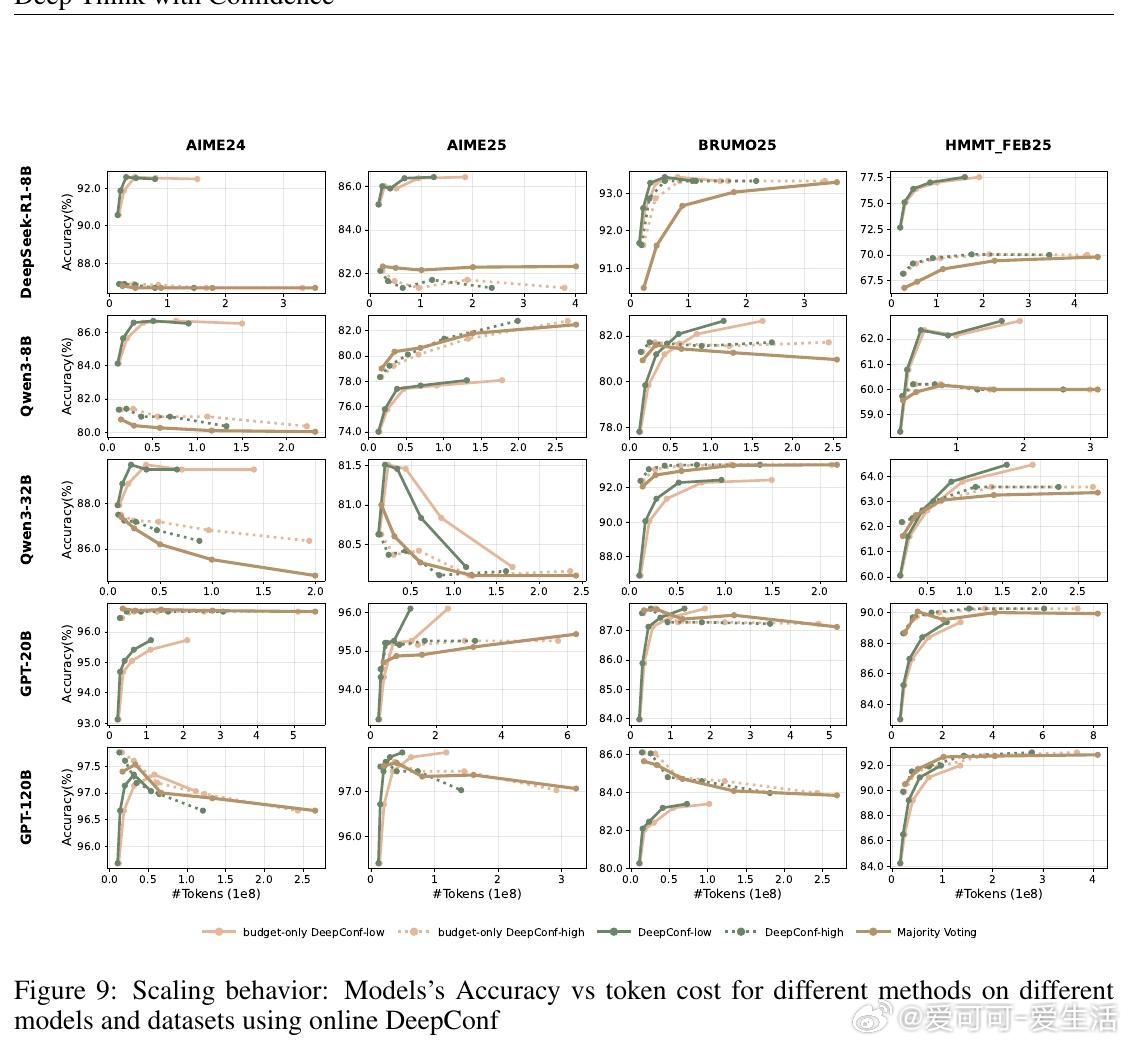

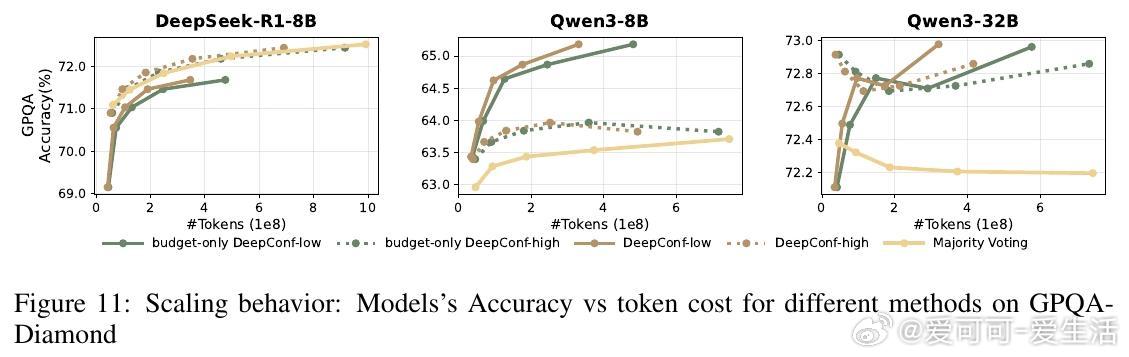

• 支持离线与在线两种思考模式,在线模式通过动态阈值提前停止低置信度路径,显著节省计算资源且保持准确率稳定。

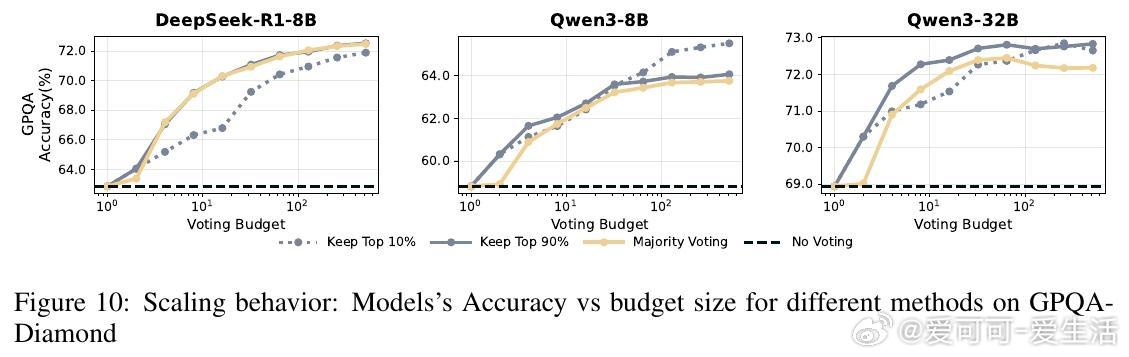

• 实验覆盖多模型(DeepSeek-8B、Qwen3-8B/32B、GPT-OSS-20B/120B)和多数据集(AIME24/25、HMMT25、BRUMO25、GPQA-Diamond),验证方法在不同规模与任务上的广泛适用性。

• 提出基于置信度的加权投票和置信度过滤策略,减少错误推理路径对最终结果的影响,提升整体推理表现。

• DeepConf体现了测试时推理压缩的潜力,为高效可扩展的LLM推理提供了实用路径。

了解详情🔗 arxiv.org/abs/2508.15260

大型语言模型推理效率置信度评估人工智能深度学习